Self-Ask Prompting: Kỹ thuật nâng cao khả năng suy luận của mô hình ngôn ngữ lớn

Self-Ask Prompting là kỹ thuật giúp mô hình ngôn ngữ lớn (LLM) cải thiện khả năng suy luận bằng cách tự đặt và trả lời các câu hỏi phụ trước khi giải quyết vấn đề chính. Phương pháp này giúp LLM xử lý các vấn đề phức tạp một cách có hệ thống và hiệu quả hơn.

Giới thiệu

Trong lĩnh vực trí tuệ nhân tạo, khả năng suy luận của các mô hình ngôn ngữ lớn (LLM) luôn là một thách thức quan trọng. Mặc dù các LLM hiện đại như GPT, Claude hay Gemini có thể lưu trữ lượng kiến thức khổng lồ, chúng vẫn thường gặp khó khăn khi phải giải quyết các vấn đề đòi hỏi suy luận phức tạp, đặc biệt là những vấn đề cần phân tích thành nhiều bước. Self-Ask Prompting ra đời như một giải pháp hiệu quả cho thách thức này.

Self-Ask Prompting là gì?

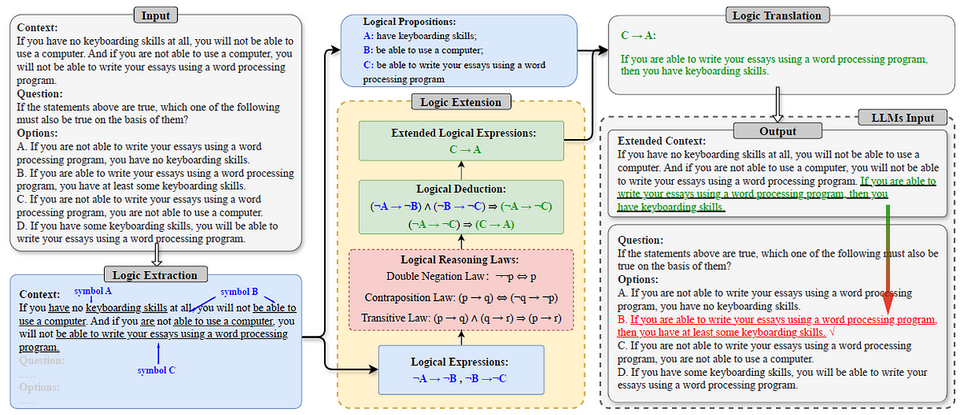

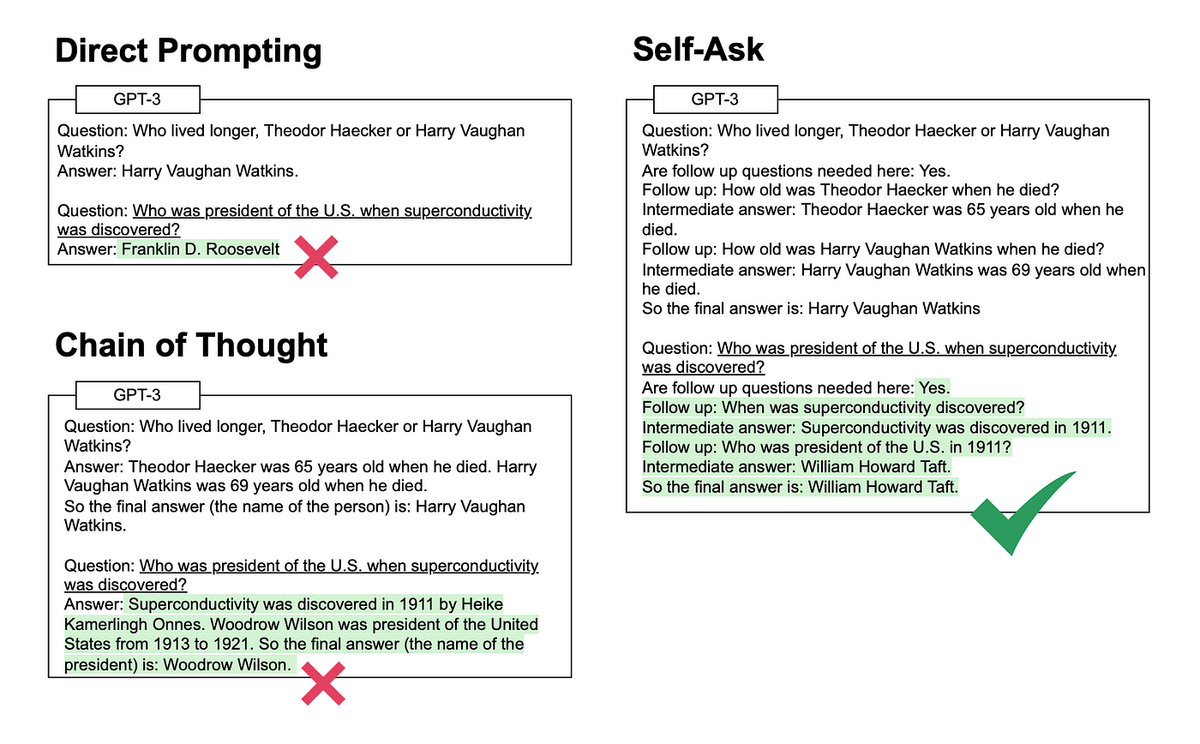

Self-Ask Prompting là một kỹ thuật prompt engineering được phát triển bởi nhóm nghiên cứu của Ofir Press và cộng sự, được công bố trong bài báo nghiên cứu "Measuring and Narrowing the Compositionality Gap in Language Models" vào năm 2023. Kỹ thuật này là sự phát triển từ phương pháp Chain-of-Thought (Chuỗi Suy Nghĩ), nhưng với cấu trúc rõ ràng hơn.

Ý tưởng cốt lõi của Self-Ask Prompting là hướng dẫn mô hình ngôn ngữ tự đặt ra các câu hỏi phụ liên quan đến vấn đề chính, sau đó trả lời từng câu hỏi phụ này một cách tuần tự trước khi đưa ra câu trả lời cuối cùng. Quá trình này mô phỏng cách con người giải quyết vấn đề phức tạp bằng cách chia nhỏ thành các bước đơn giản hơn.

Khoảng trống tổng hợp (Compositionality Gap)

Một khái niệm quan trọng được đề cập trong nghiên cứu về Self-Ask Prompting là "khoảng trống tổng hợp" (compositionality gap). Đây là hiện tượng khi mô hình ngôn ngữ có thể trả lời đúng tất cả các câu hỏi phụ nhưng lại không thể kết hợp các câu trả lời này để đưa ra giải pháp tổng thể chính xác.

Nghiên cứu của Press và cộng sự đã chỉ ra rằng khoảng trống này tồn tại ở hầu hết các mô hình ngôn ngữ lớn, và nó càng rõ rệt khi độ phức tạp của vấn đề tăng lên. Self-Ask Prompting được thiết kế để thu hẹp khoảng trống này bằng cách buộc mô hình phải xử lý vấn đề một cách có cấu trúc và từng bước.

Cách thức hoạt động của Self-Ask Prompting

Self-Ask Prompting hoạt động theo quy trình sau:

- Nhận diện vấn đề chính: Mô hình nhận câu hỏi hoặc vấn đề ban đầu từ người dùng.

- Tự đặt câu hỏi phụ: Mô hình tự phân tích vấn đề và đặt ra các câu hỏi phụ cần giải quyết trước.

- Trả lời từng câu hỏi phụ: Mô hình lần lượt trả lời từng câu hỏi phụ đã đặt ra.

- Tổng hợp thông tin: Dựa trên các câu trả lời phụ, mô hình tổng hợp thông tin để đưa ra câu trả lời cuối cùng cho vấn đề ban đầu.

Ví dụ, khi được hỏi: "Ai là tổng thống Mỹ khi Albert Einstein đến thăm Hoa Kỳ lần đầu tiên?", một mô hình sử dụng Self-Ask Prompting sẽ xử lý như sau:

Câu hỏi: Ai là tổng thống Mỹ khi Albert Einstein đến thăm Hoa Kỳ lần đầu tiên?

Tôi cần tìm hiểu thêm thông tin. Tôi sẽ tự đặt câu hỏi:

- Albert Einstein đến thăm Hoa Kỳ lần đầu tiên vào năm nào?

Để trả lời câu hỏi này, tôi cần tìm hiểu: Albert Einstein đến thăm Hoa Kỳ lần đầu tiên vào năm 1921.

Bây giờ tôi cần hỏi:

- Ai là tổng thống Mỹ vào năm 1921?

Để trả lời câu hỏi này: Warren G. Harding là tổng thống Mỹ từ năm 1921 đến 1923.

Vậy câu trả lời cuối cùng là: Warren G. Harding là tổng thống Mỹ khi Albert Einstein đến thăm Hoa Kỳ lần đầu tiên.

Ưu điểm của Self-Ask Prompting

- Cải thiện khả năng suy luận: Kỹ thuật này giúp mô hình xử lý các vấn đề phức tạp một cách có hệ thống, dẫn đến kết quả chính xác hơn.

- Minh bạch trong quá trình suy luận: Người dùng có thể theo dõi quá trình suy nghĩ của mô hình, hiểu được cách mô hình đi đến kết luận cuối cùng.

- Khả năng tích hợp với công cụ bên ngoài: Self-Ask Prompting có thể dễ dàng kết hợp với các công cụ bên ngoài như công cụ tìm kiếm để cải thiện độ chính xác của câu trả lời.

- Thu hẹp khoảng trống tổng hợp: Nghiên cứu đã chứng minh rằng Self-Ask Prompting giúp thu hẹp đáng kể khoảng trống tổng hợp trong các mô hình ngôn ngữ.

- Linh hoạt trong ứng dụng: Kỹ thuật này có thể áp dụng cho nhiều loại vấn đề khác nhau, từ hỗ trợ khách hàng, phân tích pháp lý đến nghiên cứu và sáng tạo nội dung.

So sánh với Chain-of-Thought Prompting

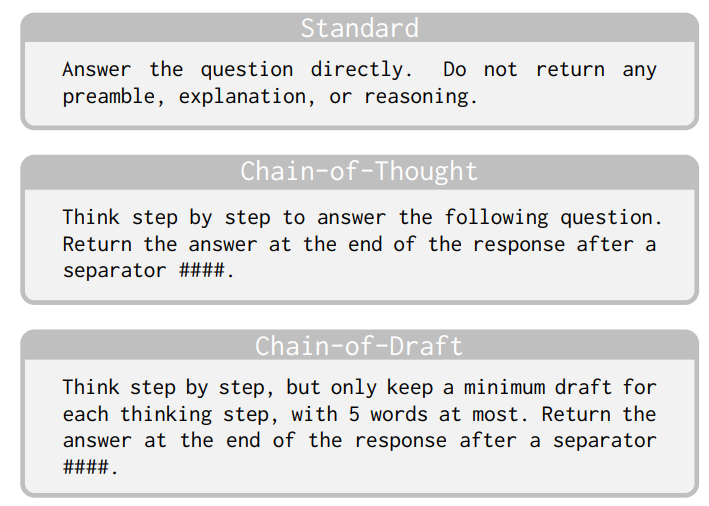

Self-Ask Prompting và Chain-of-Thought (CoT) Prompting đều là các kỹ thuật nhằm cải thiện khả năng suy luận của mô hình ngôn ngữ, nhưng có một số điểm khác biệt quan trọng:

- Cấu trúc: Self-Ask có cấu trúc rõ ràng hơn với việc đặt và trả lời các câu hỏi cụ thể, trong khi CoT thường là một dòng suy nghĩ liên tục.

- Khả năng tích hợp: Self-Ask dễ dàng tích hợp với các công cụ bên ngoài như công cụ tìm kiếm để trả lời các câu hỏi phụ.

- Hiệu quả: Nghiên cứu cho thấy Self-Ask thường hiệu quả hơn CoT trong các nhiệm vụ đòi hỏi suy luận phức tạp và nhiều bước.

- Tính chủ động: Trong Self-Ask, mô hình chủ động đặt ra các câu hỏi phụ, trong khi CoT thường là quá trình suy nghĩ tự nhiên hơn.

Ứng dụng thực tế của Self-Ask Prompting

Self-Ask Prompting có thể được áp dụng trong nhiều lĩnh vực khác nhau:

- Hỗ trợ khách hàng: Giúp chatbot xử lý các câu hỏi phức tạp từ khách hàng bằng cách chia nhỏ thành các vấn đề đơn giản hơn.

- Phân tích pháp lý: Hỗ trợ phân tích các trường hợp pháp lý phức tạp bằng cách đặt và trả lời các câu hỏi liên quan đến luật pháp.

- Nghiên cứu học thuật: Giúp tổng hợp thông tin từ nhiều nguồn và đưa ra kết luận dựa trên các dữ liệu đã thu thập.

- Sáng tạo nội dung: Cải thiện quá trình sáng tạo nội dung bằng cách đặt các câu hỏi hướng dẫn về cấu trúc, đối tượng và mục tiêu của nội dung.

- Giáo dục: Hỗ trợ học sinh giải quyết các bài toán phức tạp bằng cách hướng dẫn họ chia nhỏ vấn đề thành các bước đơn giản hơn.

Cách triển khai Self-Ask Prompting

Để triển khai Self-Ask Prompting, bạn cần:

- Thiết kế prompt mẫu: Tạo một prompt mẫu (few-shot example) minh họa cách mô hình nên tự đặt và trả lời các câu hỏi phụ.

- Hướng dẫn rõ ràng: Cung cấp hướng dẫn cụ thể cho mô hình về việc phân tích vấn đề và đặt câu hỏi phụ.

- Tích hợp công cụ bên ngoài (nếu cần): Kết hợp với các công cụ như công cụ tìm kiếm để cải thiện độ chính xác của câu trả lời.

- Kiểm tra và tinh chỉnh: Thử nghiệm prompt với nhiều loại câu hỏi khác nhau và tinh chỉnh để đạt hiệu quả tối ưu.

Ví dụ về một prompt Self-Ask đơn giản:

Khi gặp câu hỏi phức tạp, hãy chia nhỏ thành các câu hỏi đơn giản hơn và trả lời từng câu trước khi đưa ra câu trả lời cuối cùng. Hãy sử dụng định dạng sau:

Câu hỏi: [câu hỏi ban đầu]

Để trả lời, tôi cần tìm hiểu:

- [câu hỏi phụ 1]?

Để trả lời câu hỏi này: [câu trả lời cho câu hỏi phụ 1]

Tôi cũng cần biết:

- [câu hỏi phụ 2]?

Để trả lời câu hỏi này: [câu trả lời cho câu hỏi phụ 2]

Vậy câu trả lời cuối cùng là: [câu trả lời tổng hợp]

Thách thức và hạn chế

Mặc dù Self-Ask Prompting mang lại nhiều lợi ích, kỹ thuật này vẫn có một số hạn chế:

- Tốn kém tài nguyên: Quá trình đặt và trả lời nhiều câu hỏi phụ có thể tiêu tốn nhiều token hơn so với phương pháp truyền thống.

- Phụ thuộc vào chất lượng câu hỏi phụ: Hiệu quả của phương pháp phụ thuộc vào khả năng mô hình đặt ra các câu hỏi phụ phù hợp.

- Có thể dẫn đến suy luận sai: Nếu một trong các câu trả lời phụ không chính xác, kết quả cuối cùng cũng sẽ bị ảnh hưởng.

- Không phù hợp với mọi loại vấn đề: Một số vấn đề đơn giản có thể không cần đến phương pháp phức tạp này.

Kết luận

Self-Ask Prompting là một kỹ thuật prompt engineering hiệu quả giúp cải thiện khả năng suy luận của các mô hình ngôn ngữ lớn. Bằng cách hướng dẫn mô hình tự đặt và trả lời các câu hỏi phụ, kỹ thuật này giúp thu hẹp khoảng trống tổng hợp và cải thiện khả năng giải quyết các vấn đề phức tạp.

Trong bối cảnh các mô hình ngôn ngữ ngày càng được ứng dụng rộng rãi trong nhiều lĩnh vực, Self-Ask Prompting mang đến một công cụ quan trọng giúp nâng cao độ tin cậy và tính minh bạch của các hệ thống AI. Kỹ thuật này không chỉ cải thiện hiệu suất của mô hình mà còn giúp người dùng hiểu rõ hơn về quá trình suy luận đằng sau mỗi câu trả lời.

Tài liệu tham khảo

- Press, O., Zhang, M., Min, S., Schmidt, L., Smith, N. A., & Lewis, M. (2023). Measuring and Narrowing the Compositionality Gap in Language Models. Findings of the Association for Computational Linguistics: EMNLP 2023. https://arxiv.org/abs/2210.03350

- Press, O., Zhang, M., Min, S., Schmidt, L., Smith, N. A., & Lewis, M. (2023). Self-Ask: Measuring and Narrowing the Compositionality Gap in Language Models. https://ofir.io/self-ask.pdf

- Greyling, C. (2023). Self-Ask Prompting. Medium. https://cobusgreyling.medium.com/self-ask-prompting-d0805ea31faa

- Learn Prompting. (2025). Self-Ask Prompting: Improving LLM Reasoning with Step-by-Step Question Breakdown. https://learnprompting.org/docs/advanced/few_shot/self_ask

- Relevance AI. (n.d.). Master Self-Ask Prompting for Effective Problem Solving. https://relevanceai.com/prompt-engineering/master-self-ask-prompting-for-effective-problem-solving

- GitHub Repository: ofirpress/self-ask. (2023). Code and data for "Measuring and Narrowing the Compositionality Gap in Language Models". https://github.com/ofirpress/self-ask