LiteLLM: Giải pháp tích hợp Đa Nền Tảng LLM toàn diện cho Doanh Nghiệp và Nhà Phát Triển

LiteLLM là giải pháp mã nguồn mở giúp tích hợp hơn 100 API mô hình ngôn ngữ lớn (LLM) thông qua giao diện thống nhất, đơn giản hóa việc phát triển ứng dụng AI.

Giới Thiệu Chi Tiết Về LiteLLM

LiteLLM Là Gì?

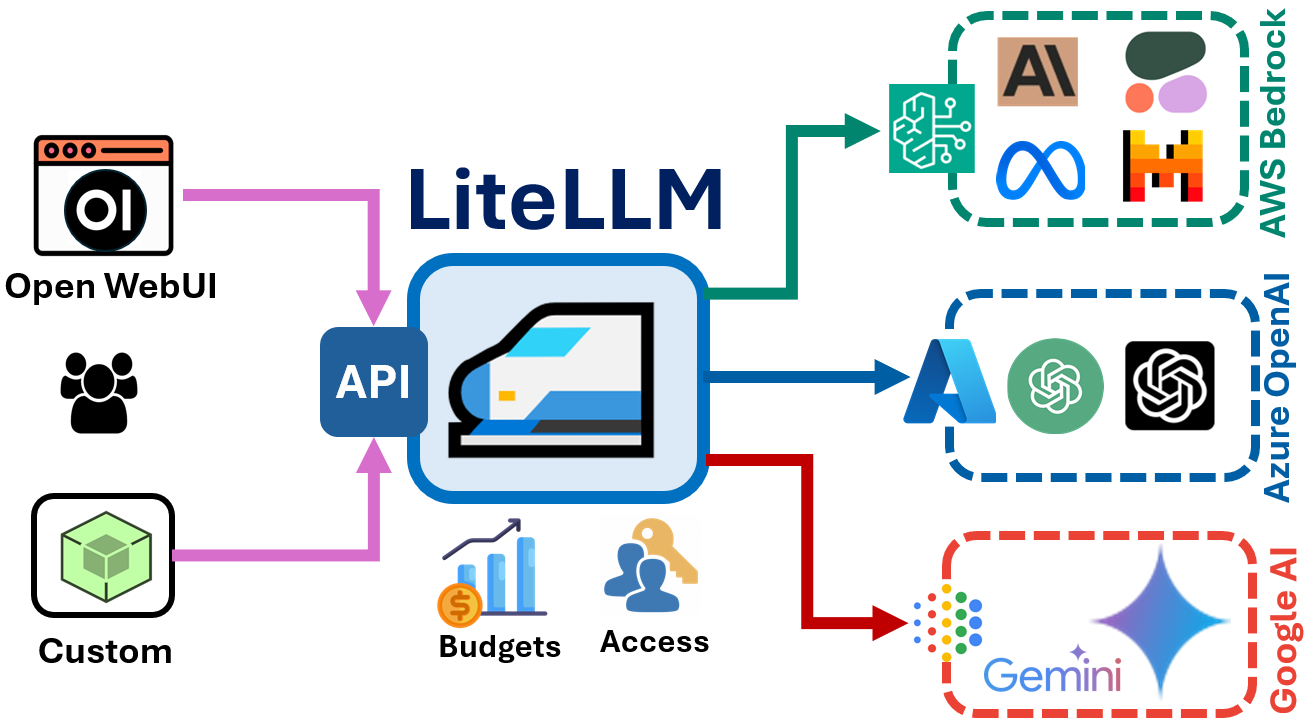

LiteLLM là một thư viện mã nguồn mở được phát triển bởi BerriAI, cung cấp giải pháp tích hợp đa nền tảng cho các mô hình ngôn ngữ lớn (LLM). Dự án này bao gồm hai thành phần chính: SDK Python và máy chủ Proxy (LLM Gateway), cho phép người dùng gọi hơn 100 API mô hình LLM khác nhau thông qua một giao diện thống nhất theo định dạng OpenAI.

LiteLLM giải quyết một trong những thách thức lớn nhất trong việc phát triển ứng dụng AI hiện nay: sự phân mảnh của các API mô hình ngôn ngữ lớn. Thay vì phải học và tích hợp nhiều API khác nhau từ các nhà cung cấp như OpenAI, Azure, Anthropic, Cohere, và nhiều nhà cung cấp khác, các nhà phát triển có thể sử dụng LiteLLM như một lớp trung gian, đơn giản hóa quy trình phát triển và triển khai.

Các Tính Năng Chính Của LiteLLM

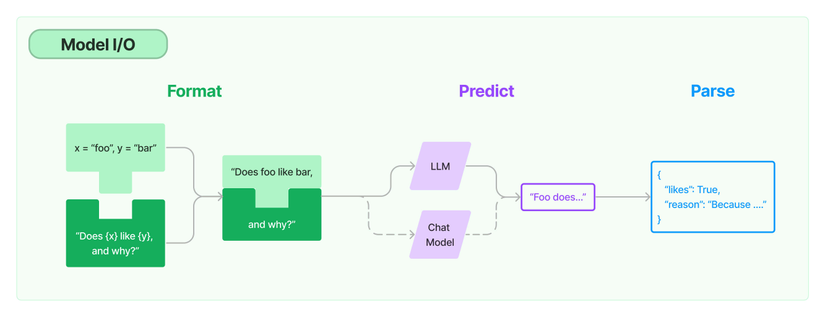

1. Giao Diện API Thống Nhất

LiteLLM chuẩn hóa việc tương tác với nhiều nhà cung cấp LLM khác nhau bằng cách sử dụng định dạng API nhất quán theo chuẩn OpenAI. Điều này cho phép các nhà phát triển chuyển đổi giữa các mô hình khác nhau mà không cần thay đổi mã nguồn của họ.

# Ví dụ sử dụng LiteLLM với nhiều mô hình khác nhau

from litellm import completion

# Sử dụng OpenAI

response = completion(model="gpt-3.5-turbo", messages=[{"role": "user", "content": "Hello!"}])

# Chuyển sang Anthropic Claude

response = completion(model="anthropic/claude-2", messages=[{"role": "user", "content": "Hello!"}])

# Chuyển sang Cohere

response = completion(model="cohere/command", messages=[{"role": "user", "content": "Hello!"}])

2. Hỗ Trợ Đa Nhà Cung Cấp

LiteLLM hỗ trợ tích hợp với hơn 100 mô hình LLM từ các nhà cung cấp hàng đầu, bao gồm:

- OpenAI (GPT-3.5, GPT-4, v.v.)

- Azure OpenAI

- Anthropic (Claude, Claude 2, v.v.)

- Google (Gemini, PaLM)

- Amazon Bedrock

- Cohere

- Meta (Llama 2, v.v.)

- Hugging Face

- Replicate

- Groq

- Vertex AI

- Và nhiều nhà cung cấp khác

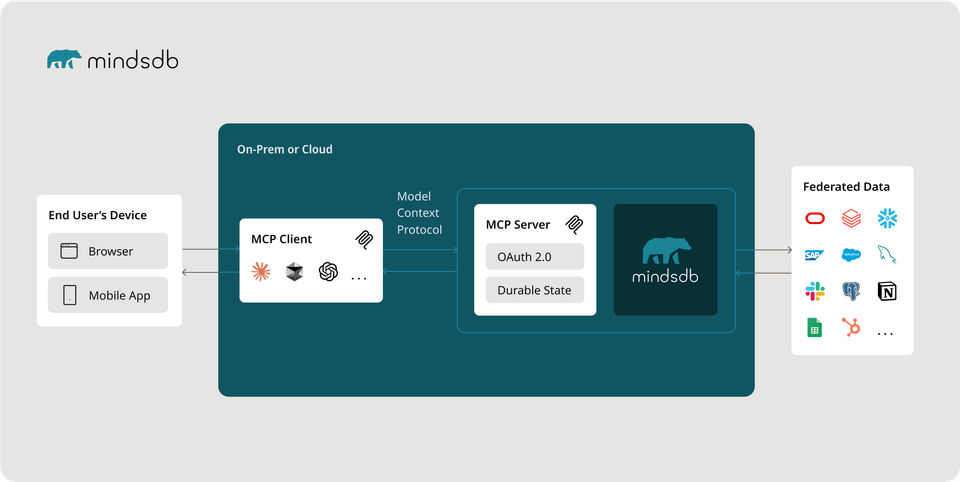

3. Máy Chủ Proxy LiteLLM

Máy chủ Proxy LiteLLM hoạt động như một cổng LLM, cho phép:

- Quản lý xác thực và phân quyền

- Theo dõi chi phí và thiết lập ngân sách

- Cân bằng tải giữa các nhà cung cấp

- Xử lý lỗi và thử lại tự động

- Tích hợp với các hệ thống giám sát và ghi nhật ký

4. Quản Lý Chi Phí và Ngân Sách

LiteLLM cung cấp các công cụ để theo dõi chi phí sử dụng LLM và thiết lập ngân sách cho người dùng hoặc nhóm người dùng. Tính năng này đặc biệt hữu ích cho các doanh nghiệp muốn kiểm soát chi phí API LLM.

5. Xử Lý Lỗi và Thử Lại

LiteLLM tự động xử lý các lỗi phổ biến từ các API LLM và cung cấp cơ chế thử lại thông minh, giúp tăng độ tin cậy của ứng dụng.

6. Tính Năng Bảo Mật

LiteLLM cung cấp các tính năng bảo mật như:

- Quản lý khóa API an toàn

- Xác thực người dùng

- Mã hóa dữ liệu

- Kiểm soát truy cập dựa trên vai trò

Cài Đặt và Cấu Hình LiteLLM

Cài Đặt SDK Python

pip install litellm

Cài Đặt Máy Chủ Proxy

# Tải mã nguồn

git clone https://github.com/BerriAI/litellm

# Di chuyển đến thư mục

cd litellm

# Thêm khóa chính - có thể thay đổi sau khi thiết lập

echo 'LITELLM_MASTER_KEY="sk-1234"' > .env

# Thêm khóa salt LiteLLM - không thể thay đổi sau khi thêm mô hình

# Được sử dụng để mã hóa/giải mã

echo 'LITELLM_SALT_KEY="salt-key-1234"' >> .env

# Chạy máy chủ proxy

litellm --config config.yaml

Cấu Hình Cơ Bản

Tạo file config.yaml với nội dung sau:

model_list:

- model_name: gpt-3.5-turbo

litellm_params:

model: azure/gpt-3.5-turbo

api_key: os.environ/AZURE_API_KEY

api_base: os.environ/AZURE_API_BASE

api_version: os.environ/AZURE_API_VERSION

- model_name: claude-2

litellm_params:

model: anthropic/claude-2

api_key: os.environ/ANTHROPIC_API_KEY

- model_name: command-nightly

litellm_params:

model: cohere/command-nightly

api_key: os.environ/COHERE_API_KEY

environment_variables:

AZURE_API_KEY: your_azure_api_key

AZURE_API_BASE: your_azure_api_base

AZURE_API_VERSION: your_azure_api_version

ANTHROPIC_API_KEY: your_anthropic_api_key

COHERE_API_KEY: your_cohere_api_key

Các Trường Hợp Sử Dụng LiteLLM

1. Phát Triển Ứng Dụng Đa Nền Tảng LLM

LiteLLM cho phép các nhà phát triển xây dựng ứng dụng có thể sử dụng nhiều mô hình LLM khác nhau mà không cần thay đổi mã nguồn. Điều này đặc biệt hữu ích khi muốn so sánh hiệu suất giữa các mô hình hoặc chuyển đổi giữa các nhà cung cấp.

2. Quản Lý Chi Phí và Tối Ưu Hóa

Doanh nghiệp có thể sử dụng LiteLLM để theo dõi và kiểm soát chi phí sử dụng LLM, đồng thời tối ưu hóa việc sử dụng bằng cách chuyển đổi giữa các nhà cung cấp dựa trên chi phí và hiệu suất.

3. Xây Dựng Hệ Thống Dự Phòng

LiteLLM cho phép xây dựng hệ thống dự phòng, tự động chuyển đổi sang nhà cung cấp LLM khác khi một nhà cung cấp gặp sự cố hoặc không khả dụng.

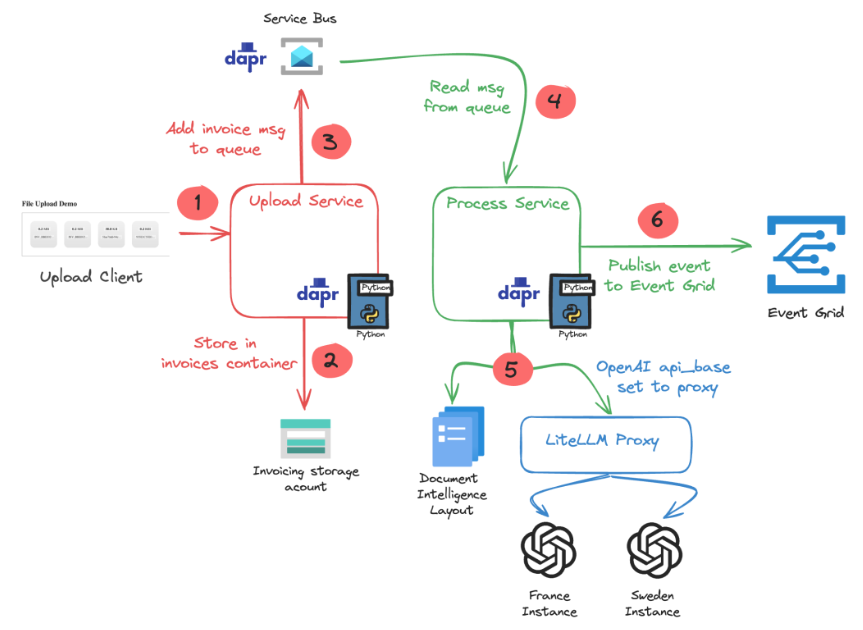

4. Tích Hợp Vào Hệ Thống Doanh Nghiệp

LiteLLM có thể được tích hợp vào hệ thống doanh nghiệp hiện có, cung cấp một lớp trung gian giữa ứng dụng và các API LLM khác nhau.

Ví Dụ Thực Tế Sử Dụng LiteLLM

Ví Dụ 1: Sử Dụng SDK Python

from litellm import completion

# Thiết lập khóa API (hoặc sử dụng biến môi trường)

import os

os.environ["OPENAI_API_KEY"] = "your-openai-api-key"

os.environ["ANTHROPIC_API_KEY"] = "your-anthropic-api-key"

# Sử dụng OpenAI

response_openai = completion(

model="gpt-3.5-turbo",

messages=[{"role": "user", "content": "Viết một bài thơ ngắn về mùa thu"}]

)

print(response_openai.choices[0].message.content)

# Sử dụng Anthropic Claude

response_claude = completion(

model="anthropic/claude-2",

messages=[{"role": "user", "content": "Viết một bài thơ ngắn về mùa thu"}]

)

print(response_claude.choices[0].message.content)

Ví Dụ 2: Sử Dụng Máy Chủ Proxy

import requests

import json

# Gửi yêu cầu đến máy chủ proxy LiteLLM

url = "http://localhost:4000/v1/chat/completions"

headers = {

"Content-Type": "application/json",

"Authorization": "Bearer sk-your-proxy-api-key"

}

data = {

"model": "gpt-3.5-turbo", # Tên mô hình đã cấu hình trong config.yaml

"messages": [{"role": "user", "content": "Viết một bài thơ ngắn về mùa thu"}]

}

response = requests.post(url, headers=headers, data=json.dumps(data))

print(response.json())

Ví Dụ 3: Cân Bằng Tải và Dự Phòng

from litellm import Router

# Cấu hình router với nhiều mô hình và cơ chế dự phòng

router = Router(

model_list=[

{

"model_name": "gpt-3.5-turbo",

"litellm_params": {

"model": "gpt-3.5-turbo",

"api_key": "your-openai-api-key"

},

"tier": "first"

},

{

"model_name": "claude-instant-1",

"litellm_params": {

"model": "anthropic/claude-instant-1",

"api_key": "your-anthropic-api-key"

},

"tier": "second"

}

],

fallbacks=[

{

"primary": {"model": "gpt-3.5-turbo", "tier": "first"},

"fallback": {"model": "claude-instant-1", "tier": "second"}

}

]

)

# Sử dụng router để gửi yêu cầu với cơ chế dự phòng

response = router.completion(

model="gpt-3.5-turbo",

messages=[{"role": "user", "content": "Viết một bài thơ ngắn về mùa thu"}]

)

print(response)

Lợi Ích Của LiteLLM

1. Giảm Độ Phức Tạp Trong Phát Triển

LiteLLM đơn giản hóa việc tích hợp nhiều API LLM khác nhau, giúp các nhà phát triển tập trung vào việc xây dựng tính năng thay vì phải học nhiều API khác nhau.

2. Tăng Tính Linh Hoạt và Khả Năng Mở Rộng

Với LiteLLM, các doanh nghiệp có thể dễ dàng chuyển đổi giữa các nhà cung cấp LLM khác nhau mà không cần thay đổi mã nguồn, tăng tính linh hoạt và khả năng mở rộng của ứng dụng.

3. Tối Ưu Hóa Chi Phí

LiteLLM cho phép theo dõi và kiểm soát chi phí sử dụng LLM, giúp doanh nghiệp tối ưu hóa ngân sách và tránh chi phí không mong muốn.

4. Tăng Độ Tin Cậy

Với cơ chế dự phòng và thử lại tự động, LiteLLM giúp tăng độ tin cậy của ứng dụng, đảm bảo rằng ứng dụng vẫn hoạt động ngay cả khi một nhà cung cấp LLM gặp sự cố.

5. Mã Nguồn Mở và Cộng Đồng Hỗ Trợ

LiteLLM là một dự án mã nguồn mở với cộng đồng hỗ trợ tích cực, đảm bảo rằng dự án được cập nhật thường xuyên và có thể đáp ứng nhu cầu của người dùng.

Thách Thức và Hạn Chế

1. Sự Khác Biệt Giữa Các Mô Hình

Mặc dù LiteLLM cung cấp một giao diện thống nhất, vẫn có sự khác biệt về khả năng và hiệu suất giữa các mô hình LLM khác nhau, có thể ảnh hưởng đến trải nghiệm người dùng.

2. Độ Trễ Bổ Sung

Việc sử dụng một lớp trung gian có thể thêm một chút độ trễ vào quá trình xử lý, mặc dù điều này thường không đáng kể so với thời gian phản hồi của các API LLM.

3. Cập Nhật API

Khi các nhà cung cấp LLM cập nhật API của họ, LiteLLM cần được cập nhật để đảm bảo tính tương thích, có thể gây ra sự gián đoạn tạm thời.

Tương Lai Của LiteLLM

LiteLLM đang tiếp tục phát triển với các tính năng mới và hỗ trợ cho nhiều mô hình LLM hơn. Dự án này đang trở thành một tiêu chuẩn trong việc tích hợp đa nền tảng LLM, với cộng đồng người dùng và nhà phát triển ngày càng tăng.

Một số hướng phát triển trong tương lai của LiteLLM bao gồm:

- Hỗ trợ cho các mô hình LLM mới và đang nổi lên

- Cải thiện hiệu suất và khả năng mở rộng

- Tích hợp sâu hơn với các công cụ và nền tảng phát triển AI

- Tính năng bảo mật và tuân thủ nâng cao

- Công cụ phân tích và tối ưu hóa chi phí mạnh mẽ hơn

Kết Luận

LiteLLM là một giải pháp mạnh mẽ cho việc tích hợp đa nền tảng LLM, cung cấp một giao diện thống nhất để truy cập hơn 100 API mô hình LLM khác nhau. Với các tính năng như quản lý chi phí, cân bằng tải, và cơ chế dự phòng, LiteLLM giúp đơn giản hóa việc phát triển ứng dụng AI và tối ưu hóa chi phí sử dụng LLM.

Dù bạn là một nhà phát triển độc lập hay một doanh nghiệp lớn, LiteLLM cung cấp các công cụ và tính năng cần thiết để tích hợp và quản lý nhiều API LLM một cách hiệu quả, giúp bạn tập trung vào việc xây dựng ứng dụng AI tuyệt vời thay vì phải lo lắng về sự phức tạp của việc tích hợp nhiều API khác nhau.

Tài Liệu Tham Khảo

- BerriAI. (2024). "LiteLLM - Python SDK, Proxy Server (LLM Gateway) to call 100+ LLM APIs in OpenAI format". GitHub Repository. https://github.com/BerriAI/litellm

- LiteLLM Documentation. (2024). "Getting Started with LiteLLM". LiteLLM Official Documentation. https://docs.litellm.ai/docs

- Vaishnavi R. (2023). "LiteLLM: A Comprehensive Analysis". Medium - Version 1. https://medium.com/version-1/litellm-a-comprehensive-analysis-4f0f4ede5bc8

- Seaflux. (2024). "Lost in LLM Land? Let LiteLLM Be Your Guide to Navigate". Seaflux Tech Blogs. https://seaflux.tech/blogs/explore-litellm-effortless-ai-projects

- AI Jumble. (2024). "LiteLLM Features, Use Cases, & Alternatives". AI Jumble Software Listings. https://aijumble.com/software-listings/litellm

- Thinh Dang. (2023). "Streamlining LLM Applications with LiteLLM Proxy: A Comprehensive Guide". Medium. https://medium.com/@thinhda/streamlining-llm-applications-with-litellm-proxy-a-comprehensive-guide-875122c00974

- LiteLLM Official Website. (2024). "LiteLLM - Unified API for 100+ LLMs". https://litellm.ai

- McDermott, R. (2024). "Centralizing Multiple AI Services with LiteLLM Proxy". Medium. https://robert-mcdermott.medium.com/centralizing-multi-vendor-llm-services-with-litellm-9874563f3062

- LiteLLM Documentation. (2024). "Set up environment - LiteLLM". https://docs.litellm.ai/docs/tutorials/installation

- Apidog. (2025). "How to Use LiteLLM with Ollama". Apidog Blog. https://apidog.com/blog/litellm-ollama