Kỹ thuật Self-Consistency trong Prompt Engineering: Nâng cao khả năng suy luận của mô hình ngôn ngữ lớn

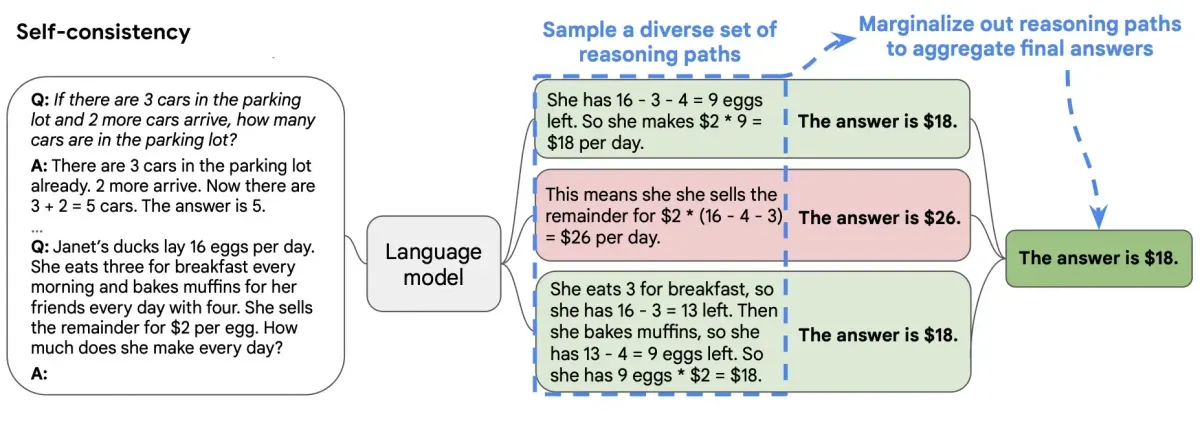

Kỹ thuật Self-Consistency là phương pháp nâng cao trong prompt engineering giúp cải thiện đáng kể khả năng suy luận của mô hình ngôn ngữ lớn bằng cách tạo ra nhiều đường dẫn suy luận và chọn kết quả nhất quán nhất.

Giới thiệu

Trong lĩnh vực trí tuệ nhân tạo, prompt engineering đóng vai trò quan trọng trong việc tối ưu hóa hiệu suất của các mô hình ngôn ngữ lớn (LLMs). Một trong những kỹ thuật tiên tiến nhất hiện nay là Self-Consistency (Tự nhất quán), được đề xuất bởi Wang và cộng sự vào năm 2022. Bài viết này sẽ giới thiệu chi tiết về kỹ thuật này, cách thức hoạt động, và cách triển khai nó trong các ứng dụng thực tế.

Self-Consistency là gì?

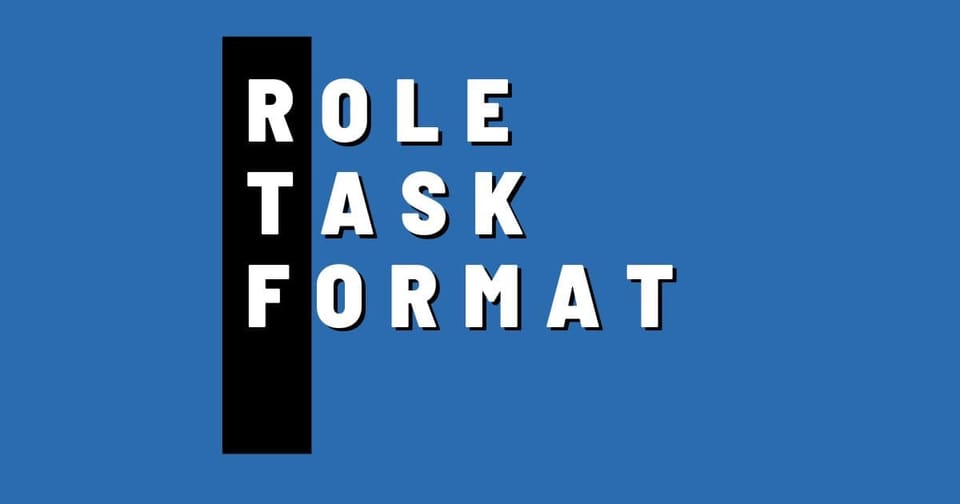

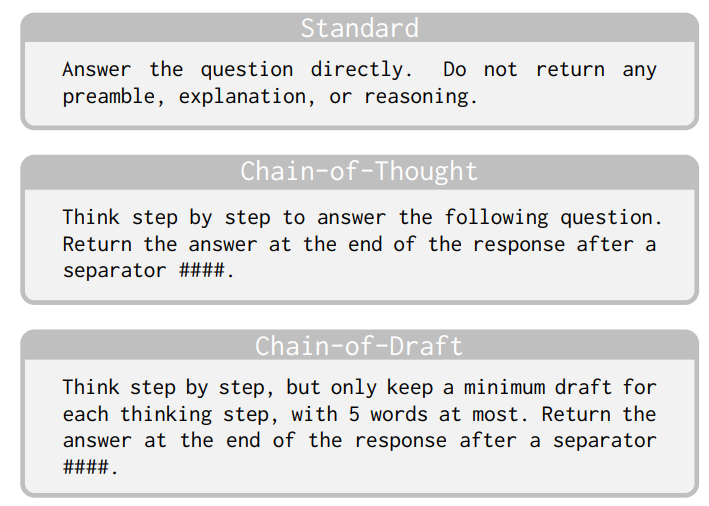

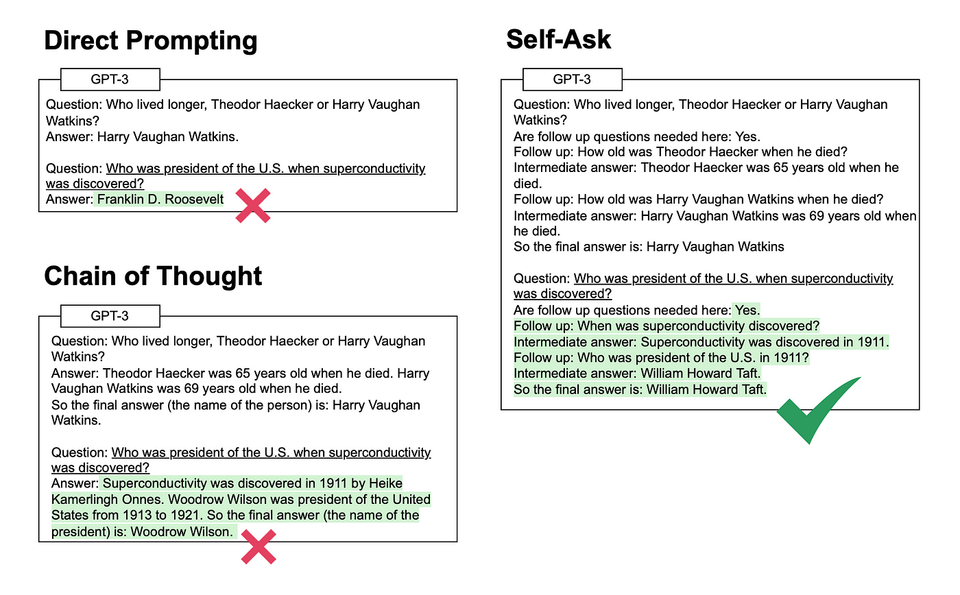

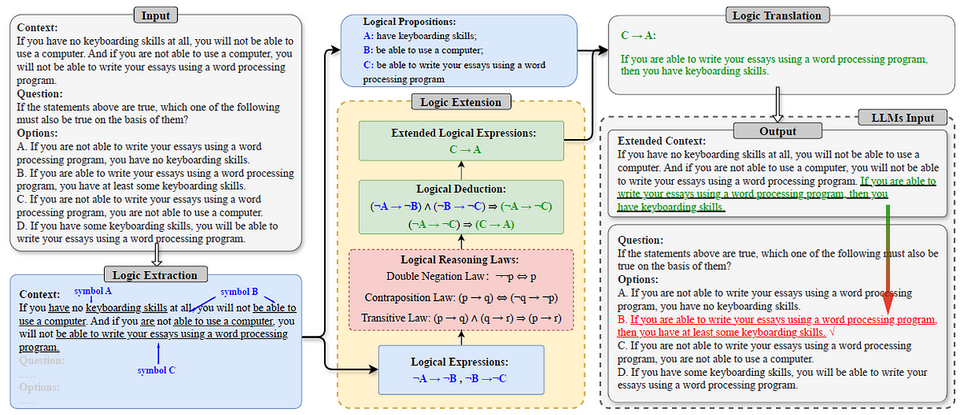

Self-Consistency là một chiến lược giải mã (decoding strategy) được thiết kế để thay thế phương pháp giải mã tham lam (greedy decoding) thông thường được sử dụng trong kỹ thuật Chain-of-Thought (CoT) prompting. Được giới thiệu trong nghiên cứu "Self-Consistency Improves Chain of Thought Reasoning in Language Models" của Wang và cộng sự (2022), kỹ thuật này nhằm nâng cao khả năng suy luận của mô hình ngôn ngữ lớn bằng cách:

- Tạo ra nhiều đường dẫn suy luận khác nhau cho cùng một vấn đề

- Chọn câu trả lời xuất hiện nhiều nhất hoặc nhất quán nhất từ các đường dẫn suy luận đó

Sự khác biệt giữa Chain-of-Thought và Self-Consistency

Để hiểu rõ giá trị của Self-Consistency, chúng ta cần so sánh nó với kỹ thuật Chain-of-Thought truyền thống:

Chain-of-Thought (CoT) Prompting:

- Yêu cầu mô hình giải thích quá trình suy luận từng bước một

- Thường sử dụng giải mã tham lam (greedy decoding) để tạo ra một đường dẫn suy luận duy nhất

- Dễ bị ảnh hưởng bởi lỗi suy luận trong một bước duy nhất

Self-Consistency:

- Mở rộng từ CoT bằng cách tạo ra nhiều đường dẫn suy luận

- Sử dụng phương pháp lấy mẫu (sampling) thay vì giải mã tham lam

- Chọn câu trả lời phổ biến nhất từ các đường dẫn suy luận khác nhau

- Giảm thiểu tác động của lỗi suy luận ngẫu nhiên

Nguyên lý hoạt động của Self-Consistency

Kỹ thuật Self-Consistency hoạt động theo các bước sau:

- Xác định vấn đề: Định nghĩa rõ ràng vấn đề hoặc câu hỏi cần giải quyết.

- Tạo prompt CoT: Thiết kế prompt theo phương pháp Chain-of-Thought, yêu cầu mô hình giải thích quá trình suy luận.

- Tạo nhiều đường dẫn suy luận: Thay vì chỉ lấy một kết quả, tạo ra nhiều đường dẫn suy luận khác nhau bằng cách:

- Sử dụng tham số nhiệt độ (temperature) cao hơn để tăng tính đa dạng

- Chạy cùng một prompt nhiều lần với cài đặt lấy mẫu khác nhau

- Tổng hợp kết quả: Phân tích các câu trả lời từ nhiều đường dẫn suy luận và chọn câu trả lời xuất hiện nhiều nhất.

Ưu điểm của Self-Consistency

Nghiên cứu của Wang và cộng sự (2022) đã chứng minh rằng Self-Consistency mang lại nhiều cải tiến đáng kể:

- Cải thiện độ chính xác: Tăng hiệu suất đáng kể trên nhiều bài kiểm tra suy luận phức tạp, bao gồm:

- GSM8K (tăng 17.9%)

- SVAMP (tăng 11.0%)

- AQuA (tăng 12.2%)

- StrategyQA (tăng 6.4%)

- ARC-challenge (tăng 3.9%)

- Khả năng phục hồi lỗi: Giảm thiểu tác động của lỗi suy luận ngẫu nhiên trong một đường dẫn duy nhất.

- Tính linh hoạt: Có thể áp dụng cho nhiều loại nhiệm vụ suy luận khác nhau, từ toán học đến suy luận thông thường.

Triển khai Self-Consistency trong thực tế

Dưới đây là hướng dẫn cách triển khai Self-Consistency với Python và OpenAI API:

from openai import OpenAI

import collections

client = OpenAI()

def self_consistency_prompting(prompt, num_samples=5, temperature=0.7):

"""

Thực hiện Self-Consistency prompting

Args:

prompt: Prompt CoT cần sử dụng

num_samples: Số lượng đường dẫn suy luận cần tạo

temperature: Tham số nhiệt độ để tăng tính đa dạng

Returns:

Câu trả lời phổ biến nhất

"""

responses = []

# Tạo nhiều đường dẫn suy luận

for _ in range(num_samples):

response = client.chat.completions.create(

model="gpt-4",

messages=[{"role": "user", "content": prompt}],

temperature=temperature

)

responses.append(response.choices[0].message.content)

# Trích xuất câu trả lời cuối cùng từ mỗi đường dẫn suy luận

final_answers = []

for response in responses:

# Giả sử câu trả lời cuối cùng nằm sau "Vậy câu trả lời là: "

try:

answer = response.split("Vậy câu trả lời là: ")[1].strip()

final_answers.append(answer)

except:

# Xử lý trường hợp không tìm thấy định dạng trên

final_answers.append(response.strip())

# Chọn câu trả lời phổ biến nhất

answer_counts = collections.Counter(final_answers)

most_common_answer = answer_counts.most_common(1)[0][0]

return most_common_answer

# Ví dụ sử dụng

math_problem = """

Hãy giải bài toán sau đây từng bước một:

Một lớp học có 64 học sinh tham gia thử nghiệm đội thi đố vui. Nếu 36 học sinh không được chọn vào đội và số còn lại được chia thành 4 nhóm, mỗi nhóm sẽ có bao nhiêu học sinh?

Hãy suy nghĩ từng bước một và đưa ra câu trả lời.

"""

answer = self_consistency_prompting(math_problem, num_samples=5, temperature=0.8)

print("Câu trả lời nhất quán nhất:", answer)

Ví dụ minh họa

Hãy xem xét một ví dụ cụ thể về bài toán đố:

Prompt: "Một lớp học có 64 học sinh tham gia thử nghiệm đội thi đố vui. Nếu 36 học sinh không được chọn vào đội và số còn lại được chia thành 4 nhóm, mỗi nhóm sẽ có bao nhiêu học sinh?"

Đường dẫn suy luận 1:

Tổng số học sinh: 64

Số học sinh không được chọn: 36

Số học sinh được chọn: 64 - 36 = 28

Số nhóm: 4

Số học sinh mỗi nhóm: 28 ÷ 4 = 7

Vậy câu trả lời là: 7 học sinh

Đường dẫn suy luận 2:

Tổng cộng có 64 học sinh.

36 học sinh không được chọn.

Số học sinh được chọn là 64 - 36 = 28 học sinh.

28 học sinh này được chia thành 4 nhóm.

Mỗi nhóm có 28 ÷ 4 = 7 học sinh.

Vậy câu trả lời là: 7 học sinh

Đường dẫn suy luận 3:

Tổng số học sinh là 64.

Số học sinh không được chọn là 36.

Số học sinh được chọn vào đội là 64 - 36 = 28.

Số học sinh này được chia thành 4 nhóm.

Mỗi nhóm có 28/4 = 7 học sinh.

Vậy câu trả lời là: 7 học sinh

Trong ví dụ này, tất cả các đường dẫn suy luận đều dẫn đến cùng một câu trả lời: 7 học sinh. Tuy nhiên, trong các bài toán phức tạp hơn, các đường dẫn suy luận có thể dẫn đến các câu trả lời khác nhau, và Self-Consistency sẽ chọn câu trả lời phổ biến nhất.

Các biến thể và mở rộng của Self-Consistency

Kể từ khi được giới thiệu, Self-Consistency đã được phát triển thành nhiều biến thể khác nhau:

- Universal Self-Consistency: Mở rộng kỹ thuật để áp dụng cho nhiều loại nhiệm vụ khác nhau, không chỉ giới hạn trong các bài toán suy luận.

- Contrastive Self-Consistency: Kết hợp Self-Consistency với học đối nghịch (contrastive learning) để cải thiện hiệu suất.

- Random-CoT: Sử dụng các đường dẫn suy luận ngẫu nhiên thay vì các đường dẫn được thiết kế cẩn thận.

- Active-Prompt: Kết hợp Self-Consistency với kỹ thuật học chủ động để tối ưu hóa prompt.

Kết hợp Self-Consistency với các kỹ thuật khác

Self-Consistency có thể kết hợp hiệu quả với các kỹ thuật prompt engineering khác:

- Tree-of-Thoughts (ToT): Mở rộng Self-Consistency bằng cách khám phá nhiều đường dẫn suy luận theo cấu trúc cây, cho phép mô hình đánh giá và quay lui khi cần thiết.

- Retrieval-Augmented Generation (RAG): Kết hợp Self-Consistency với RAG để tạo ra nhiều đường dẫn suy luận dựa trên thông tin được truy xuất.

- Few-shot CoT: Sử dụng Self-Consistency với few-shot CoT để tạo ra nhiều đường dẫn suy luận dựa trên các ví dụ được cung cấp.

Thách thức và hạn chế

Mặc dù mang lại nhiều lợi ích, Self-Consistency vẫn có một số hạn chế:

- Chi phí tính toán: Yêu cầu nhiều lần chạy mô hình, làm tăng chi phí và thời gian xử lý.

- Phụ thuộc vào chất lượng prompt: Hiệu quả của Self-Consistency vẫn phụ thuộc vào chất lượng của prompt CoT ban đầu.

- Không đảm bảo tính chính xác tuyệt đối: Mặc dù cải thiện hiệu suất, nhưng không đảm bảo luôn đưa ra câu trả lời đúng.

Kết luận

Self-Consistency là một bước tiến quan trọng trong lĩnh vực prompt engineering, cung cấp một phương pháp hiệu quả để nâng cao khả năng suy luận của các mô hình ngôn ngữ lớn. Bằng cách tạo ra nhiều đường dẫn suy luận và chọn câu trả lời nhất quán nhất, kỹ thuật này giúp giảm thiểu tác động của lỗi suy luận ngẫu nhiên và cải thiện độ chính xác tổng thể.

Khi các mô hình ngôn ngữ lớn ngày càng được ứng dụng rộng rãi trong các nhiệm vụ đòi hỏi suy luận phức tạp, Self-Consistency sẽ trở thành một công cụ quan trọng trong bộ công cụ của các kỹ sư AI và nhà phát triển ứng dụng.

Tài liệu tham khảo

- Wang, X., Wei, J., Schuurmans, D., Le, Q., Chi, E., & Zhou, D. (2022). Self-Consistency Improves Chain of Thought Reasoning in Language Models. arXiv preprint arXiv:2203.11171. https://arxiv.org/abs/2203.11171

- Wang, X., Wei, J., Schuurmans, D., Le, Q., Chi, E., & Zhou, D. (2022). Self-Consistency Improves Chain of Thought Reasoning in Language Models. ICLR 2023. https://openreview.net/forum?id=1PL1NIMMrw

- Prompt Engineering Guide. (2024). Self-Consistency. https://promptingguide.ai/techniques/consistency

- PromptHub. (2025). Self-Consistency and Universal Self-Consistency Prompting. https://prompthub.us/blog/self-consistency-and-universal-self-consistency-prompting

- Analytics Vidhya. (2024). What is Self-Consistency in Prompt Engineering? https://analyticsvidhya.com/blog/2024/07/self-consistency-in-prompt-engineering

- Google Research. (2022). Self-Consistency Improves Chain of Thought Reasoning in Language Models. https://research.google/pubs/self-consistency-improves-chain-of-thought-reasoning-in-language-models