Kỹ thuật Generated Knowledge Prompting trong Prompt Engineering

Khám phá kỹ thuật Generated Knowledge Prompting - phương pháp nâng cao hiệu quả của mô hình ngôn ngữ lớn bằng cách tận dụng khả năng tự tạo kiến thức, đặc biệt hiệu quả cho các bài toán suy luận thông thường.

1. Giới thiệu về Generated Knowledge Prompting

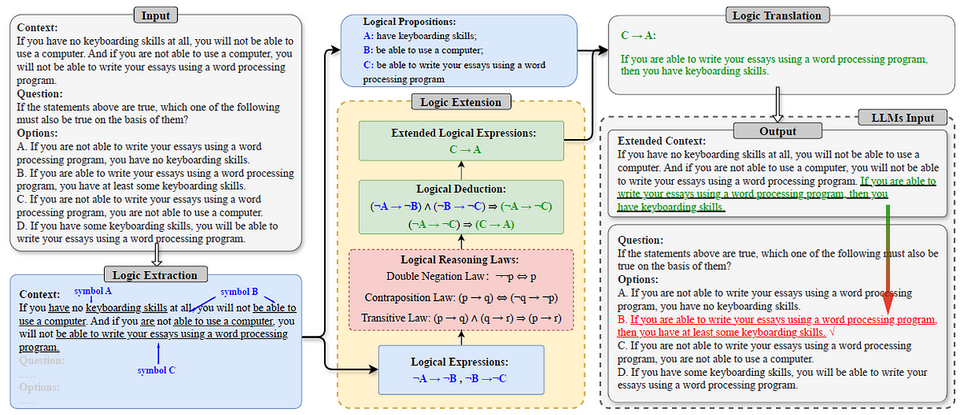

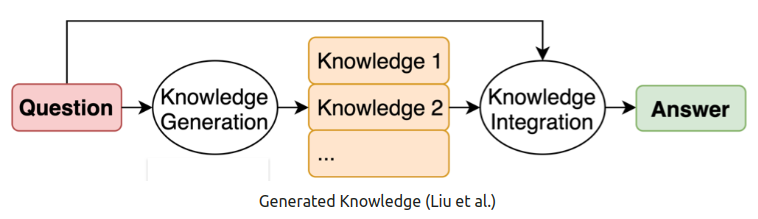

Generated Knowledge Prompting (GKP) là một kỹ thuật prompt engineering tiên tiến được giới thiệu bởi Liu và cộng sự trong nghiên cứu năm 2022. Kỹ thuật này tận dụng khả năng của các mô hình ngôn ngữ lớn (LLMs) để tạo ra kiến thức liên quan trước khi đưa ra câu trả lời cuối cùng, từ đó nâng cao chất lượng và độ chính xác của kết quả.

Ý tưởng cốt lõi của GKP là thay vì chỉ yêu cầu mô hình trả lời trực tiếp một câu hỏi, chúng ta đầu tiên yêu cầu mô hình tạo ra các thông tin kiến thức liên quan đến vấn đề, sau đó sử dụng những kiến thức này như một phần của prompt để đưa ra câu trả lời cuối cùng.

2. Cơ sở lý thuyết và nghiên cứu

Nghiên cứu "Generated Knowledge Prompting for Commonsense Reasoning" của Liu và cộng sự (2022) đã chứng minh rằng việc tạo ra kiến thức từ chính mô hình ngôn ngữ có thể cải thiện đáng kể hiệu suất của các mô hình trong các bài toán suy luận thông thường (commonsense reasoning).

Các tác giả đã phát triển phương pháp này với mục tiêu khắc phục hạn chế của các mô hình ngôn ngữ lớn khi xử lý các bài toán đòi hỏi kiến thức thông thường mà không cần phải sử dụng các cơ sở dữ liệu kiến thức có cấu trúc bên ngoài.

Nghiên cứu đã thử nghiệm phương pháp này trên bốn bộ dữ liệu suy luận thông thường và đạt được kết quả vượt trội, đặc biệt trong các lĩnh vực như suy luận số học (NumerSense) và kiến thức thông thường tổng quát (CommonsenseQA 2.0).

3. Quy trình thực hiện Generated Knowledge Prompting

Quy trình thực hiện GKP thường bao gồm các bước sau:

Bước 1: Tạo ra kiến thức

Đầu tiên, yêu cầu mô hình ngôn ngữ tạo ra các phát biểu kiến thức liên quan đến vấn đề cần giải quyết. Việc này thường được thực hiện bằng cách sử dụng một định dạng prompt chung.

Bước 2: Lựa chọn kiến thức phù hợp

Từ các phát biểu kiến thức được tạo ra, lựa chọn những kiến thức có liên quan nhất hoặc hữu ích nhất cho vấn đề. Trong nghiên cứu gốc, các tác giả đã chọn kiến thức dựa trên xác suất dự đoán tối đa.

Bước 3: Tích hợp kiến thức vào prompt

Kết hợp kiến thức đã chọn vào prompt cuối cùng để mô hình đưa ra câu trả lời.

4. Ví dụ minh họa

Ví dụ 1: Suy luận thông thường

Prompt ban đầu:

Câu hỏi: Trong môn golf, mục tiêu là ghi được nhiều điểm hơn người khác. Đúng hay Sai?

Áp dụng GKP:

Tạo kiến thức: Trong môn golf, người chơi cố gắng hoàn thành mỗi lỗ golf với số cú đánh ít nhất có thể. Điểm số trong golf được tính bằng tổng số cú đánh, vì vậy điểm số càng thấp càng tốt.

Câu hỏi: Trong môn golf, mục tiêu là ghi được nhiều điểm hơn người khác. Đúng hay Sai?

Trả lời: Sai. Trong môn golf, mục tiêu là có tổng số cú đánh (điểm) ít nhất có thể. Người chơi có điểm thấp nhất là người chiến thắng.

Ví dụ 2: Suy luận số học

Prompt ban đầu:

Câu hỏi: Hy Lạp lớn hơn Mexico. Đúng hay Sai?

Áp dụng GKP:

Tạo kiến thức: Hy Lạp có diện tích khoảng 131.957 km², trong khi Mexico có diện tích khoảng 1.964.375 km², khiến Mexico lớn hơn Hy Lạp khoảng 1.389%.

Câu hỏi: Hy Lạp lớn hơn Mexico. Đúng hay Sai?

Trả lời: Sai. Dựa trên diện tích, Mexico lớn hơn Hy Lạp rất nhiều. Mexico có diện tích khoảng 1.964.375 km², trong khi Hy Lạp chỉ có khoảng 131.957 km².

Ví dụ 3: Ứng dụng thực tế

Tình huống: Một khách hàng đang sử dụng chatbot để hỏi về việc đặt lại chuyến bay.

Prompt ban đầu:

Khách hàng: Tôi cần đổi chuyến bay của mình.

Áp dụng GKP:

Tạo kiến thức: Việc đổi chuyến bay thường đòi hỏi thông tin về mã đặt chỗ, ngày bay hiện tại, và ngày bay mới mong muốn. Các hãng hàng không thường có chính sách đổi vé với các mức phí khác nhau tùy thuộc vào loại vé và thời gian thay đổi.

Khách hàng: Tôi cần đổi chuyến bay của mình.

Trả lời: Tôi rất vui được giúp bạn đổi chuyến bay. Để hỗ trợ bạn hiệu quả, tôi cần một số thông tin:

1. Mã đặt chỗ của bạn

2. Ngày và chuyến bay hiện tại

3. Ngày và chuyến bay mới bạn muốn đổi sang

Xin lưu ý rằng có thể phát sinh phí đổi vé tùy thuộc vào loại vé bạn đã mua và thời gian thay đổi. Bạn có thể cung cấp những thông tin này để tôi hỗ trợ bạn tốt hơn không?

5. Ưu điểm của Generated Knowledge Prompting

- Cải thiện độ chính xác: Bằng cách tạo ra kiến thức liên quan trước, mô hình có thêm thông tin để đưa ra câu trả lời chính xác hơn.

- Không cần cơ sở dữ liệu bên ngoài: Phương pháp này không đòi hỏi truy cập vào các cơ sở dữ liệu kiến thức có cấu trúc bên ngoài.

- Linh hoạt và dễ áp dụng: Có thể áp dụng cho nhiều loại bài toán khác nhau mà không cần huấn luyện lại mô hình.

- Tăng tính minh bạch: Kiến thức được tạo ra giúp người dùng hiểu rõ hơn về cơ sở lý luận đằng sau câu trả lời của mô hình.

- Hiệu quả với các mô hình lớn: Đặc biệt hiệu quả khi áp dụng với các mô hình ngôn ngữ lớn như T5-11B và các biến thể của nó.

6. Hạn chế và thách thức

- Chất lượng kiến thức tạo ra: Hiệu quả của phương pháp phụ thuộc vào chất lượng của kiến thức được tạo ra, có thể không nhất quán hoặc chính xác trong mọi trường hợp.

- Tốn kém tài nguyên: Quá trình tạo kiến thức và lựa chọn kiến thức phù hợp đòi hỏi thêm tài nguyên tính toán.

- Không phù hợp với mọi bài toán: Một số bài toán đơn giản có thể không cần đến kiến thức bổ sung, khiến phương pháp này trở nên dư thừa.

- Khả năng tạo ra thông tin sai lệch: Nếu kiến thức được tạo ra không chính xác, có thể dẫn đến kết quả sai lệch.

7. Ứng dụng thực tế

Generated Knowledge Prompting có thể được áp dụng trong nhiều lĩnh vực:

- Hệ thống hỏi đáp: Cải thiện độ chính xác của câu trả lời bằng cách tạo ra kiến thức liên quan.

- Chatbot hỗ trợ khách hàng: Nâng cao khả năng hiểu và giải quyết vấn đề của khách hàng.

- Hệ thống giáo dục: Hỗ trợ học sinh bằng cách cung cấp kiến thức nền tảng trước khi giải thích các khái niệm phức tạp.

- Phân tích dữ liệu: Tạo ra các hiểu biết sâu sắc hơn về dữ liệu bằng cách tạo ra kiến thức liên quan.

- Viết nội dung: Cải thiện chất lượng nội dung được tạo ra bằng cách tích hợp kiến thức chuyên môn.

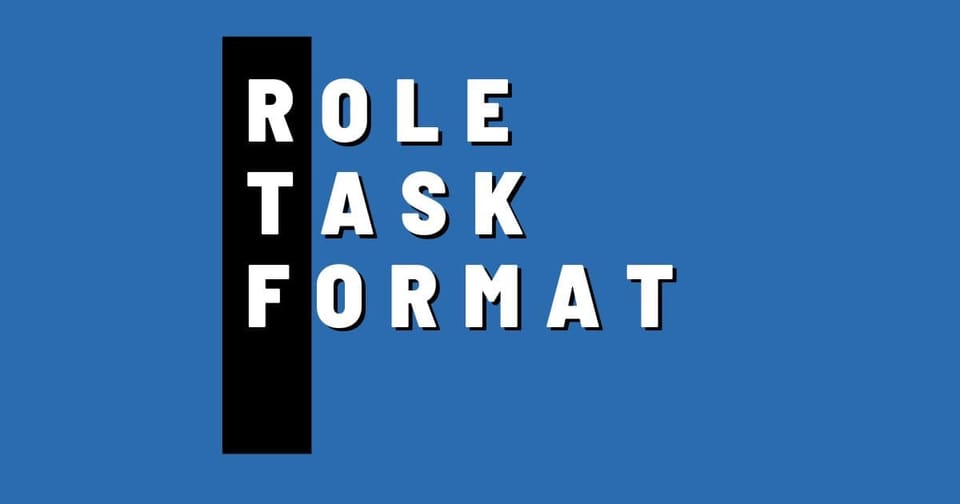

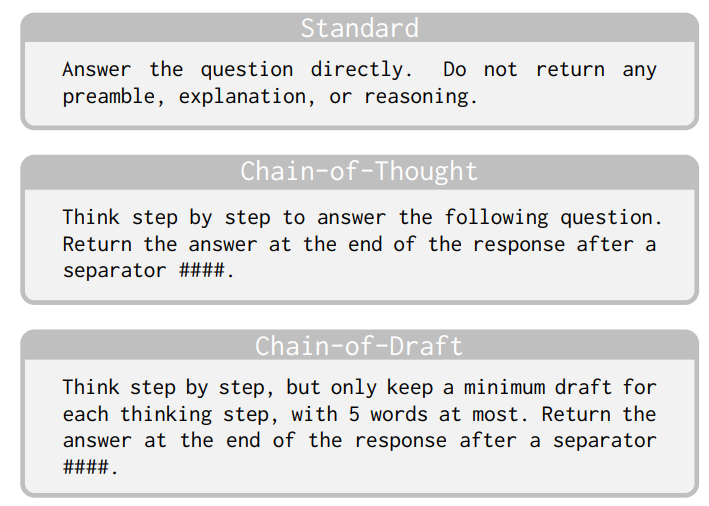

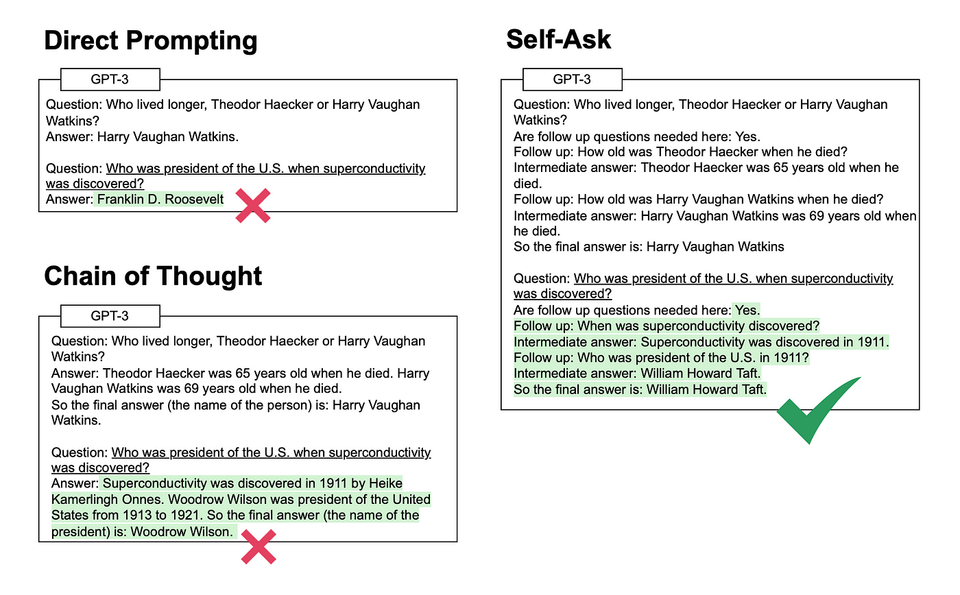

8. So sánh với các kỹ thuật prompt engineering khác

| Kỹ thuật | Đặc điểm chính | So với Generated Knowledge Prompting |

|---|---|---|

| Few-shot Prompting | Cung cấp một số ví dụ trong prompt | GKP tạo ra kiến thức thay vì dựa vào ví dụ có sẵn |

| Chain-of-Thought | Yêu cầu mô hình suy luận từng bước | GKP tập trung vào tạo kiến thức trước, sau đó mới suy luận |

| Self-Consistency | Tạo nhiều đường dẫn suy luận và chọn kết quả phổ biến nhất | GKP tạo và chọn kiến thức trước khi suy luận |

| ReAct | Kết hợp suy luận và hành động | GKP tập trung vào việc tạo kiến thức hơn là hành động |

9. Hướng phát triển trong tương lai

- Tự động hóa lựa chọn kiến thức: Phát triển các thuật toán tốt hơn để tự động lựa chọn kiến thức phù hợp nhất.

- Kết hợp với các kỹ thuật khác: Tích hợp GKP với các kỹ thuật prompt engineering khác như Chain-of-Thought để tạo ra hiệu quả tốt hơn.

- Đánh giá độ tin cậy của kiến thức: Phát triển các phương pháp để đánh giá độ tin cậy của kiến thức được tạo ra.

- Tối ưu hóa hiệu suất: Cải thiện hiệu quả tính toán của quá trình tạo và lựa chọn kiến thức.

- Mở rộng sang các lĩnh vực chuyên biệt: Áp dụng GKP trong các lĩnh vực chuyên biệt như y học, luật pháp, và khoa học.

10. Kết luận

Generated Knowledge Prompting là một kỹ thuật prompt engineering mạnh mẽ giúp cải thiện hiệu suất của các mô hình ngôn ngữ lớn trong các bài toán suy luận thông thường. Bằng cách tận dụng khả năng của chính mô hình để tạo ra kiến thức liên quan, kỹ thuật này giúp nâng cao độ chính xác và độ tin cậy của câu trả lời mà không cần truy cập vào các cơ sở dữ liệu kiến thức bên ngoài.

Mặc dù còn một số hạn chế, GKP đã chứng minh hiệu quả trong nhiều ứng dụng thực tế và có tiềm năng phát triển mạnh mẽ trong tương lai, đặc biệt khi kết hợp với các kỹ thuật prompt engineering khác.

Tài liệu tham khảo

- Liu, J., Liu, A., Lu, X., Welleck, S., West, P., Le Bras, R., Choi, Y., & Hajishirzi, H. (2022). Generated Knowledge Prompting for Commonsense Reasoning. Proceedings of the 60th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), 3154–3166. https://aclanthology.org/2022.acl-long.225/

- Liu, J., Liu, A., Lu, X., Welleck, S., West, P., Le Bras, R., Choi, Y., & Hajishirzi, H. (2022). Generated Knowledge Prompting for Commonsense Reasoning. arXiv preprint arXiv:2110.08387. https://arxiv.org/abs/2110.08387

- Prompt Engineering Guide. (2024). Generated Knowledge Prompting. https://promptingguide.ai/techniques/knowledge

- Learn Prompting. (2024). Generated Knowledge in Prompts: Boosting AI Accuracy and Reliability. https://learnprompting.org/docs/intermediate/generated_knowledge

- PromptHub Blog. (2025). Generated Knowledge Prompting. https://prompthub.us/blog/generated-knowledge-prompting

- Shwartz, V., West, P., Le Bras, R., Bhagavatula, C., & Choi, Y. (2020). Unsupervised Commonsense Question Answering with Self-Talk. Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing (EMNLP), 4615–4629.

- Paranjape, B., Joshi, A., Khot, T., Zettlemoyer, L., & Hajishirzi, H. (2021). Hindsight: Posterior-guided training of retrievers for improved open-ended generation. arXiv preprint arXiv:2110.07752.

- Wei, J., Wang, X., Schuurmans, D., Bosma, M., Ichter, B., Xia, F., Chi, E., Le, Q., & Zhou, D. (2022). Chain of Thought Prompting Elicits Reasoning in Large Language Models. arXiv preprint arXiv:2201.11903.