Chain-of-Thought Prompting: Phương Pháp Nâng Cao Khả Năng Suy Luận Của Mô Hình Ngôn Ngữ Lớn

Chain-of-Thought Prompting giúp mô hình AI phân rã bài toán phức tạp thành các bước suy luận trung gian, nâng cao đáng kể hiệu suất giải quyết vấn đề đòi hỏi tư duy logic và suy luận đa bước.

Giới thiệu về Chain-of-Thought Prompting

Chain-of-Thought Prompting (CoT) là một kỹ thuật prompt engineering được giới thiệu bởi Wei và cộng sự vào năm 2022 trong bài báo nghiên cứu "Chain-of-Thought Prompting Elicits Reasoning in Large Language Models". Phương pháp này đã tạo ra bước đột phá trong việc cải thiện khả năng suy luận của các mô hình ngôn ngữ lớn (LLM) bằng cách khuyến khích mô hình thể hiện quá trình tư duy từng bước một trước khi đưa ra kết luận cuối cùng.

Nguyên lý hoạt động của Chain-of-Thought Prompting

Cơ chế cơ bản

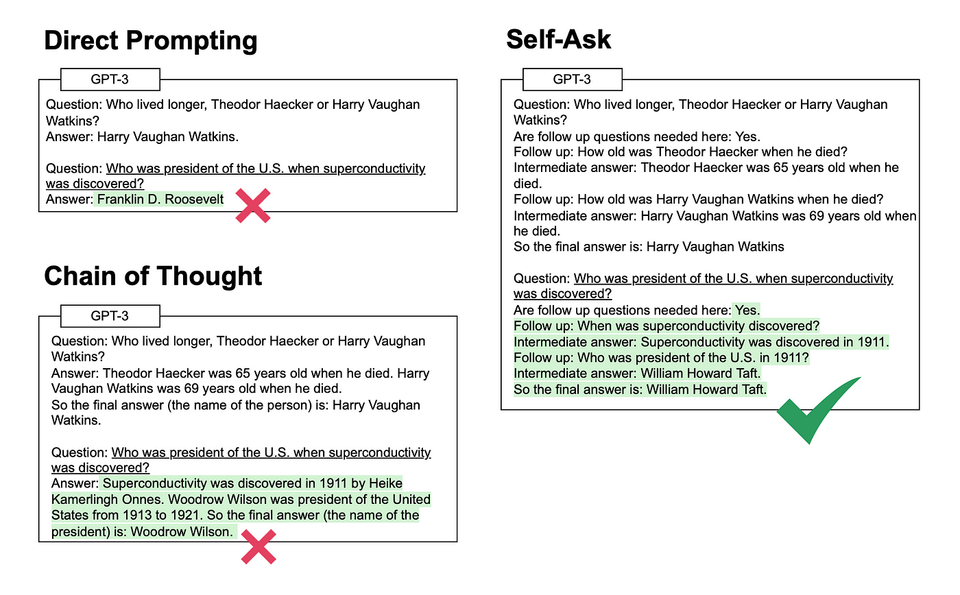

Chain-of-Thought Prompting hoạt động dựa trên nguyên tắc đơn giản nhưng hiệu quả: thay vì yêu cầu mô hình ngôn ngữ đưa ra câu trả lời trực tiếp, kỹ thuật này khuyến khích mô hình "suy nghĩ từng bước" - tức là chia nhỏ quá trình giải quyết vấn đề thành một chuỗi các bước suy luận trung gian, dẫn đến kết quả cuối cùng.

Ví dụ, thay vì hỏi trực tiếp:

Tính 15 x 27 + 14 x 33

Với CoT, chúng ta có thể yêu cầu:

Hãy tính 15 x 27 + 14 x 33 bằng cách giải thích từng bước.

Mô hình sẽ đáp ứng bằng cách hiển thị quá trình tư duy:

Để tính 15 x 27 + 14 x 33, tôi sẽ thực hiện từng bước:

Bước 1: Tính 15 x 27 = 405

Bước 2: Tính 14 x 33 = 462

Bước 3: Cộng hai kết quả: 405 + 462 = 867

Vậy kết quả là 867.

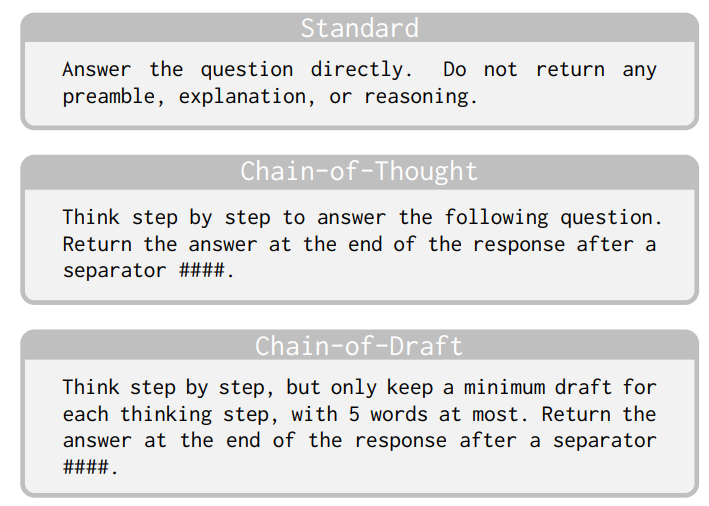

Các loại Chain-of-Thought Prompting

1. Few-shot Chain-of-Thought Prompting

Đây là phương pháp ban đầu được đề xuất bởi Wei và cộng sự (2022). Trong phương pháp này, người dùng cung cấp một số ví dụ (thường là 3-8 ví dụ) về cách giải quyết vấn đề tương tự với quá trình suy luận từng bước. Mô hình sau đó học cách áp dụng phương pháp tương tự cho vấn đề mới.

2. Zero-shot Chain-of-Thought Prompting

Được giới thiệu bởi Kojima và cộng sự, Zero-shot CoT đơn giản hóa quá trình bằng cách chỉ thêm cụm từ như "Hãy suy nghĩ từng bước" vào cuối prompt, mà không cần cung cấp ví dụ. Đáng ngạc nhiên, cách tiếp cận đơn giản này vẫn mang lại cải thiện đáng kể về hiệu suất cho nhiều nhiệm vụ suy luận.

Ứng dụng của Chain-of-Thought Prompting

1. Giải quyết bài toán toán học phức tạp

CoT đặc biệt hiệu quả trong việc giải quyết các bài toán toán học đa bước. Nghiên cứu của Wei và cộng sự cho thấy cải thiện đáng kể trong các nhiệm vụ như tính toán số học, giải phương trình, và giải các bài toán đố.

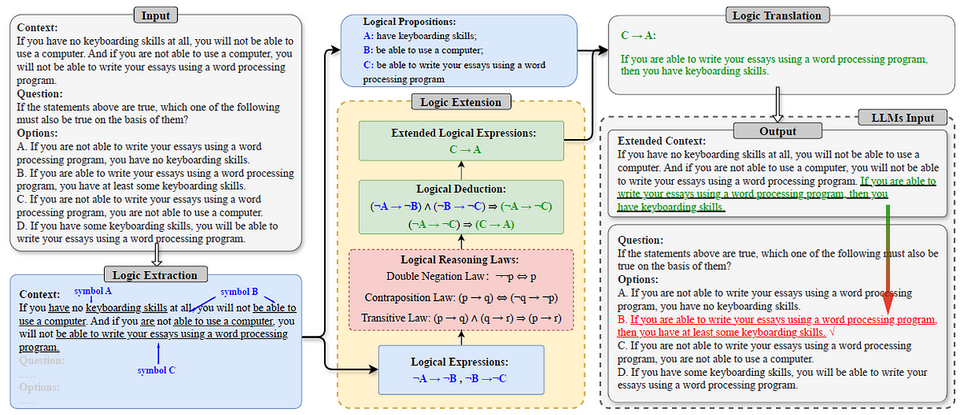

2. Suy luận logic và lập luận thông thường

CoT giúp mô hình xử lý tốt hơn các nhiệm vụ đòi hỏi suy luận logic và hiểu biết thông thường. Ví dụ, khi phân tích tình huống phức tạp hoặc giải quyết các bài toán đòi hỏi hiểu biết về thế giới thực.

3. Lập trình và giải quyết vấn đề kỹ thuật

Trong lĩnh vực lập trình, CoT giúp mô hình phân tích vấn đề, thiết kế giải pháp, và viết mã theo từng bước logic, dẫn đến kết quả chính xác hơn.

4. Phân tích văn bản và trả lời câu hỏi

CoT cải thiện khả năng của mô hình trong việc hiểu và phân tích văn bản phức tạp, trích xuất thông tin quan trọng, và trả lời các câu hỏi đòi hỏi suy luận dựa trên nội dung.

Ưu điểm của Chain-of-Thought Prompting

1. Cải thiện độ chính xác

Nghiên cứu đã chứng minh rằng CoT cải thiện đáng kể độ chính xác của mô hình trong các nhiệm vụ đòi hỏi suy luận phức tạp. Theo Wei và cộng sự (2022), hiệu suất trên một số nhiệm vụ toán học tăng từ 18% lên 57% khi sử dụng CoT.

2. Tính minh bạch và khả năng giải thích

CoT làm cho quá trình suy luận của mô hình trở nên minh bạch hơn, cho phép người dùng hiểu cách mô hình đi đến kết luận. Điều này đặc biệt quan trọng trong các ứng dụng yêu cầu tính giải thích được, như y tế hoặc tài chính.

3. Khả năng phát hiện và sửa lỗi

Bằng cách hiển thị quá trình suy luận từng bước, CoT giúp dễ dàng phát hiện lỗi trong quá trình suy luận của mô hình, cho phép người dùng can thiệp và điều chỉnh khi cần thiết.

4. Khả năng mở rộng cho nhiều loại nhiệm vụ

CoT có thể áp dụng cho nhiều loại nhiệm vụ khác nhau, từ toán học, lập luận thông thường, đến lập trình và phân tích văn bản.

Hạn chế và thách thức

1. Yêu cầu về kích thước mô hình

Nghiên cứu cho thấy CoT chỉ thực sự hiệu quả với các mô hình đủ lớn (thường là trên 100 tỷ tham số). Các mô hình nhỏ hơn có thể không thể hiện cải thiện đáng kể khi sử dụng CoT.

2. Chất lượng của quá trình suy luận

Mặc dù CoT cải thiện hiệu suất, nhưng quá trình suy luận của mô hình không phải lúc nào cũng hoàn hảo. Mô hình có thể đưa ra các bước suy luận sai hoặc không liên quan, dẫn đến kết quả không chính xác.

3. Độ dài của phản hồi

CoT tạo ra các phản hồi dài hơn do bao gồm các bước suy luận trung gian, điều này có thể không phù hợp cho một số ứng dụng yêu cầu phản hồi ngắn gọn.

Các biến thể và cải tiến của Chain-of-Thought Prompting

1. Self-consistency Chain-of-Thought

Được giới thiệu bởi Wang và cộng sự, phương pháp này tạo ra nhiều chuỗi suy luận khác nhau cho cùng một vấn đề, sau đó chọn kết quả phổ biến nhất làm câu trả lời cuối cùng, cải thiện độ chính xác tổng thể.

2. Tree of Thoughts (ToT)

Mở rộng từ CoT, Tree of Thoughts cho phép mô hình khám phá nhiều đường suy luận khác nhau, tạo thành một cấu trúc cây, và chọn đường đi tối ưu nhất, đặc biệt hiệu quả cho các vấn đề phức tạp.

3. Least-to-Most Prompting

Phương pháp này chia vấn đề phức tạp thành các vấn đề con đơn giản hơn, giải quyết từng vấn đề con theo thứ tự tăng dần về độ phức tạp, và sử dụng kết quả từ các vấn đề trước để giải quyết vấn đề tiếp theo.

Hướng dẫn thực hành sử dụng Chain-of-Thought Prompting

1. Thiết kế prompt hiệu quả

Để tận dụng tối đa CoT, hãy thiết kế prompt rõ ràng yêu cầu mô hình giải thích quá trình suy luận. Ví dụ:

Hãy giải bài toán sau đây bằng cách giải thích từng bước suy luận của bạn:

[Mô tả bài toán]

2. Sử dụng Few-shot CoT cho vấn đề phức tạp

Đối với các vấn đề phức tạp, cung cấp một số ví dụ về cách giải quyết vấn đề tương tự với quá trình suy luận từng bước. Ví dụ:

Ví dụ 1:

Bài toán: [Mô tả bài toán 1]

Giải pháp:

Bước 1: [Mô tả bước 1]

Bước 2: [Mô tả bước 2]

...

Kết luận: [Kết luận]

Ví dụ 2:

[Tương tự như trên]

Bây giờ, hãy giải bài toán sau đây bằng cách giải thích từng bước suy luận của bạn:

[Mô tả bài toán mới]

3. Sử dụng Zero-shot CoT cho vấn đề đơn giản hơn

Đối với các vấn đề đơn giản hơn, chỉ cần thêm cụm từ "Hãy suy nghĩ từng bước" vào cuối prompt:

[Mô tả bài toán]

Hãy suy nghĩ từng bước.

4. Kết hợp với các kỹ thuật khác

Kết hợp CoT với các kỹ thuật prompt engineering khác như Role Prompting hoặc Self-consistency để cải thiện hiệu suất:

Bạn là một chuyên gia toán học. Hãy giải bài toán sau đây bằng cách giải thích từng bước suy luận của bạn một cách chi tiết và chính xác:

[Mô tả bài toán]

Tương lai của Chain-of-Thought Prompting

Kỹ thuật Chain-of-Thought Prompting đang tiếp tục phát triển với nhiều hướng nghiên cứu đầy hứa hẹn:

- Kết hợp với học tăng cường từ phản hồi của con người (RLHF): Cải thiện chất lượng của quá trình suy luận dựa trên phản hồi của con người.

- Tự động tạo ra chuỗi suy luận: Phát triển các phương pháp để tự động tạo ra các chuỗi suy luận chất lượng cao mà không cần sự can thiệp của con người.

- Ứng dụng trong các lĩnh vực chuyên biệt: Điều chỉnh CoT cho các lĩnh vực chuyên biệt như y học, luật pháp, và khoa học.

- Kết hợp với các công cụ bên ngoài: Tích hợp CoT với các công cụ bên ngoài như máy tính, cơ sở dữ liệu, hoặc các API để mở rộng khả năng giải quyết vấn đề.

Kết luận

Chain-of-Thought Prompting đại diện cho một bước tiến quan trọng trong việc cải thiện khả năng suy luận của các mô hình ngôn ngữ lớn. Bằng cách khuyến khích mô hình thể hiện quá trình tư duy từng bước, CoT không chỉ cải thiện độ chính xác mà còn tăng tính minh bạch và khả năng giải thích của mô hình.

Mặc dù còn một số hạn chế, CoT và các biến thể của nó đang mở ra những khả năng mới trong việc sử dụng AI cho các nhiệm vụ đòi hỏi suy luận phức tạp. Khi các mô hình ngôn ngữ tiếp tục phát triển, chúng ta có thể kỳ vọng thấy nhiều ứng dụng và cải tiến hơn nữa của kỹ thuật này trong tương lai.

Tài liệu tham khảo

- Wei, J., Wang, X., Schuurmans, D., Bosma, M., Ichter, B., Xia, F., Chi, E., Le, Q., & Zhou, D. (2022). Chain-of-Thought Prompting Elicits Reasoning in Large Language Models. arXiv:2201.11903. https://arxiv.org/abs/2201.11903

- Kojima, T., Gu, S. S., Reid, M., Matsuo, Y., & Iwasawa, Y. (2022). Large Language Models are Zero-Shot Reasoners. arXiv:2205.11916. https://arxiv.org/abs/2205.11916

- Wang, X., Wei, J., Schuurmans, D., Le, Q., Chi, E., & Zhou, D. (2022). Self-Consistency Improves Chain of Thought Reasoning in Language Models. arXiv:2203.11171. https://arxiv.org/abs/2203.11171

- Trí tuệ nhân tạo. (2023). Chain of Thought Prompting là gì? https://trituenhantao.io/kien-thuc/chain-of-thought-prompting-la-gi

- Vinalink Media. (2024). Chain of Thought Prompting là gì? Tất cả bạn cần biết. https://vinalink.com/cam-nang-ai/chain-of-thought-prompting-la-gi.html

- VietnamLab. (2023). Ứng dụng kỹ thuật Chain of Thought Prompting và Zero-Shot Chain of Thought vào việc huấn luyện mô hình LLM. https://blog.vietnamlab.vn/chain-of-thought-prompting-and-zero-shot-chain-of-thought

- Learn Prompting. (2024). Zero-Shot Chain-of-Thought. https://learnprompting.org/docs/intermediate/zero_shot_cot

- Prompt Engineering Guide. (2024). Chain-of-Thought (CoT) Prompting. https://promptingguide.ai/techniques/cot

- Viblo. (2023). ChatGPT Series 7.1: Prompt Engineering (1). https://viblo.asia/p/chatgpt-series-71-prompt-engineering-1-pgjLN27EL32

- Viblo. (2023). ChatGPT Series 7.2: Prompt Engineering (2). https://viblo.asia/p/chatgpt-series-72-prompt-engineering-2-yZjJYK5lVOE