Chain-of-Draft: Phương pháp suy luận hiệu quả hơn cho Mô hình Ngôn ngữ Lớn

Chain-of-Draft là phương pháp mới giúp mô hình AI suy luận hiệu quả hơn bằng cách tạo ra các bước trung gian ngắn gọn, tiết kiệm đến 90% chi phí tính toán mà vẫn duy trì độ chính xác cao như phương pháp Chain-of-Thought truyền thống.

1. Giới thiệu về Chain-of-Draft

Chain-of-Draft (CoD) là một phương pháp nhắc nhở (prompting) mới được giới thiệu trong một bài nghiên cứu từ các nhà khoa học Silei Xu, Wenhao Xi, Lingxiao Zhao và Pengcheng He tại Zoom Communications vào tháng 2 năm 2025. Phương pháp này được lấy cảm hứng từ cách con người giải quyết vấn đề phức tạp - thay vì viết ra từng bước suy luận chi tiết, chúng ta thường tạo ra các ghi chú ngắn gọn, súc tích chỉ chứa những thông tin thiết yếu.

Tên gọi "Chain-of-Draft" (Chuỗi Bản nháp) phản ánh bản chất của phương pháp này: tạo ra các bước suy luận trung gian ngắn gọn, giống như những bản nháp tối thiểu, thay vì những giải thích dài dòng.

1.1 Bối cảnh và động lực nghiên cứu

Sự phát triển của Chain-of-Draft xuất phát từ một thách thức cơ bản trong việc sử dụng các mô hình ngôn ngữ lớn (LLM) cho các tác vụ suy luận phức tạp: chi phí tính toán cao và độ trễ lớn. Các phương pháp truyền thống như Chain-of-Thought (CoT) đã chứng minh hiệu quả trong việc cải thiện khả năng suy luận của LLM, nhưng chúng yêu cầu mô hình tạo ra các chuỗi suy luận dài dòng, dẫn đến việc sử dụng nhiều token và tăng chi phí API.

Các nhà nghiên cứu đã quan sát cách con người thực sự giải quyết vấn đề và nhận thấy rằng chúng ta hiếm khi diễn đạt mọi chi tiết trong quá trình suy nghĩ. Thay vào đó, chúng ta thường sử dụng các ghi chú ngắn gọn, ký hiệu tốc ký và các bản nháp tối thiểu để nắm bắt thông tin cần thiết. Quan sát này đã truyền cảm hứng cho việc phát triển Chain-of-Draft.

1.2 Định nghĩa và nguyên tắc cốt lõi

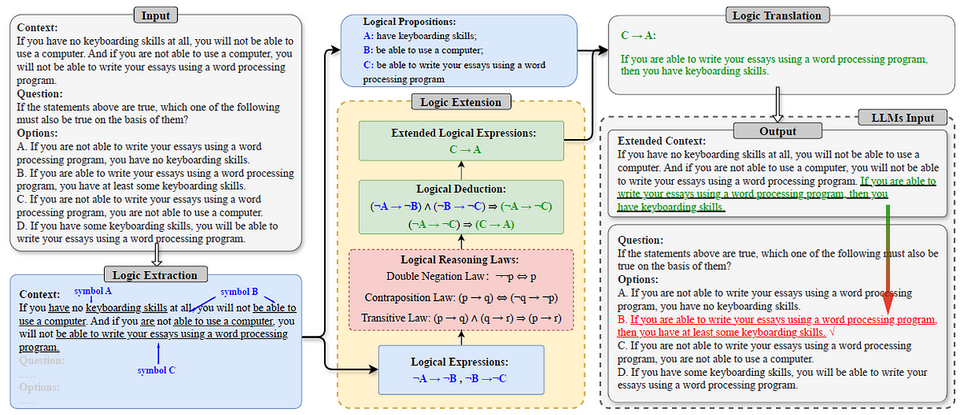

Chain-of-Draft là một chiến lược nhắc nhở (prompting) khuyến khích các mô hình ngôn ngữ lớn tạo ra các bước suy luận trung gian ngắn gọn, súc tích nhưng giàu thông tin khi giải quyết các tác vụ phức tạp. Thay vì tạo ra các giải thích chi tiết ở mỗi bước như trong Chain-of-Thought, CoD tập trung vào việc nắm bắt thông tin thiết yếu với số lượng token tối thiểu.

Các nguyên tắc cốt lõi của Chain-of-Draft bao gồm:

- Tối giản hóa: Loại bỏ các chi tiết không cần thiết và tập trung vào thông tin thiết yếu.

- Trừu tượng hóa: Sử dụng các biểu diễn trừu tượng (như phương trình, ký hiệu) khi có thể.

- Hiệu quả thông tin: Đảm bảo mỗi token được sử dụng mang lại giá trị thông tin cao.

- Bảo toàn suy luận: Duy trì tính minh bạch và chính xác trong quá trình suy luận mặc dù ngắn gọn.

2. Cơ sở lý thuyết và nguồn gốc

2.1 Mô phỏng quá trình nhận thức của con người

Chain-of-Draft được xây dựng dựa trên hiểu biết về cách con người thực sự suy nghĩ và giải quyết vấn đề. Khi đối mặt với các vấn đề phức tạp, con người thường không diễn đạt mọi bước suy luận một cách chi tiết. Thay vào đó, chúng ta sử dụng:

- Ghi chú ngắn gọn: Chỉ ghi lại những điểm chính, không phải câu đầy đủ.

- Ký hiệu tốc ký: Sử dụng các ký hiệu và viết tắt để tiết kiệm thời gian và không gian.

- Biểu diễn trừu tượng: Sử dụng các phương trình, biểu đồ, hoặc các biểu diễn trực quan khác.

- Tập trung có chọn lọc: Chỉ chú ý đến thông tin liên quan trực tiếp đến vấn đề.

Nghiên cứu trong lĩnh vực khoa học nhận thức đã chỉ ra rằng khả năng trừu tượng hóa và tập trung vào thông tin thiết yếu là một phần quan trọng của trí thông minh con người. Chain-of-Draft áp dụng nguyên tắc này vào việc thiết kế prompt cho các mô hình ngôn ngữ lớn.

2.2 Sự khác biệt với các phương pháp suy luận khác

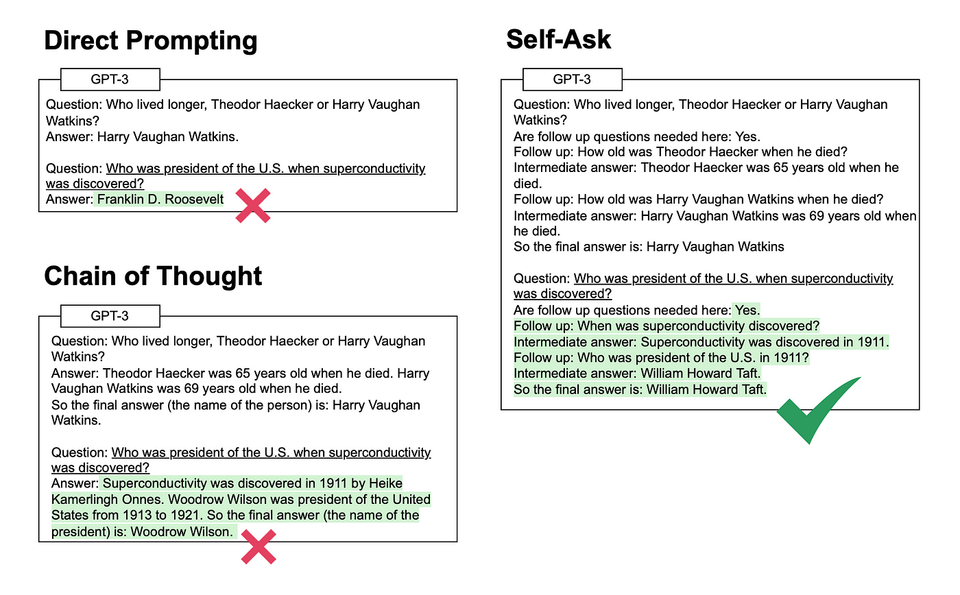

Chain-of-Draft khác biệt với các phương pháp suy luận khác như sau:

- Chain-of-Thought (CoT):

- CoT yêu cầu mô hình diễn đạt từng bước suy luận chi tiết bằng câu đầy đủ.

- CoD khuyến khích mô hình sử dụng các biểu diễn ngắn gọn, súc tích.

- CoT tiêu thụ nhiều token hơn, trong khi CoD tiết kiệm token đáng kể.

- Zero-shot và Few-shot Learning:

- Zero-shot và Few-shot tập trung vào việc cung cấp ví dụ để mô hình học cách giải quyết vấn đề.

- CoD tập trung vào cách mô hình biểu diễn quá trình suy luận, không phải cách nó học từ ví dụ.

- Self-consistency:

- Self-consistency tạo ra nhiều chuỗi suy luận và chọn kết quả phổ biến nhất.

- CoD tập trung vào việc tối ưu hóa một chuỗi suy luận duy nhất để giảm token.

- Tree of Thoughts:

- Tree of Thoughts khám phá nhiều nhánh suy luận có thể có.

- CoD tập trung vào việc làm cho một đường dẫn suy luận hiệu quả hơn.

3. Chain-of-Draft so với Chain-of-Thought

3.1 So sánh chi tiết

Chain-of-Thought (CoT) là phương pháp nhắc nhở phổ biến giúp các mô hình ngôn ngữ lớn (LLM) thực hiện suy luận phức tạp bằng cách yêu cầu mô hình diễn giải từng bước suy nghĩ chi tiết. Mặc dù hiệu quả, phương pháp này có nhược điểm là tạo ra nhiều token, dẫn đến chi phí tính toán cao và độ trễ lớn.

Bảng so sánh chi tiết giữa hai phương pháp:

| Khía cạnh | Chain-of-Thought (CoT) | Chain-of-Draft (CoD) |

|---|---|---|

| Độ dài bước suy luận | Câu đầy đủ, giải thích chi tiết | Cụm từ ngắn, tối đa 5 từ mỗi bước |

| Mức độ trừu tượng | Thấp, diễn giải chi tiết | Cao, sử dụng biểu diễn trừu tượng |

| Lượng token sử dụng | Cao (cơ sở so sánh) | Thấp (giảm 70-90%) |

| Độ trễ | Cao | Thấp |

| Chi phí API | Cao | Thấp |

| Khả năng giải thích | Cao, dễ hiểu cho người dùng | Trung bình, có thể khó hiểu hơn |

| Phù hợp với tác vụ | Đa dạng, đặc biệt là các tác vụ phức tạp | Tốt nhất cho các tác vụ có thể biểu diễn ngắn gọn |

3.2 Ví dụ minh họa chi tiết

Để hiểu rõ hơn sự khác biệt giữa CoT và CoD, hãy xem xét các ví dụ sau:

Ví dụ 1: Bài toán toán học

Bài toán: "Một cửa hàng bán 3 loại trái cây: táo, cam và chuối. Giá của một quả táo là $2, một quả cam là $3, và một quả chuối là $1. Nếu John mua 2 quả táo, 3 quả cam và 4 quả chuối, tổng số tiền anh ấy phải trả là bao nhiêu?"

Chain-of-Thought (CoT):

Để tính tổng số tiền John phải trả, tôi cần tính giá trị của từng loại trái cây và cộng chúng lại.

- John mua 2 quả táo. Mỗi quả táo có giá $2. Vậy 2 quả táo có giá: 2 × $2 = $4.

- John mua 3 quả cam. Mỗi quả cam có giá $3. Vậy 3 quả cam có giá: 3 × $3 = $9.

- John mua 4 quả chuối. Mỗi quả chuối có giá $1. Vậy 4 quả chuối có giá: 4 × $1 = $4.

- Tổng số tiền John phải trả là: $4 + $9 + $4 = $17.

Vậy John phải trả tổng cộng $17.

Chain-of-Draft (CoD):

Táo: 2 × $2 = $4

Cam: 3 × $3 = $9

Chuối: 4 × $1 = $4

Tổng: $4 + $9 + $4 = $17

####

$17

Ví dụ 2: Suy luận logic

Bài toán: "Tất cả học sinh lớp A đều thích toán. Maria là học sinh lớp A. Vậy Maria có thích toán không?"

Chain-of-Thought (CoT):

Để giải quyết bài toán này, tôi cần áp dụng quy tắc suy luận logic.

Trước tiên, chúng ta biết rằng "Tất cả học sinh lớp A đều thích toán". Đây là một mệnh đề phổ quát.

Tiếp theo, chúng ta biết rằng "Maria là học sinh lớp A". Đây là một sự kiện cụ thể.

Áp dụng quy tắc tam đoạn luận (syllogism), nếu tất cả X đều là Y, và Z là X, thì Z cũng là Y.

Trong trường hợp này, X là "học sinh lớp A", Y là "người thích toán", và Z là "Maria".

Vì Maria là học sinh lớp A, và tất cả học sinh lớp A đều thích toán, nên Maria thích toán.

Vậy câu trả lời là: Có, Maria thích toán.

Chain-of-Draft (CoD):

Lớp A → thích toán

Maria ∈ lớp A

⇒ Maria thích toán

####

Có

Những ví dụ này minh họa cách Chain-of-Draft có thể đạt được kết quả tương tự như Chain-of-Thought nhưng với số lượng token ít hơn đáng kể.

4. Phương pháp luận và thực hiện

4.1 Thiết kế prompt cho Chain-of-Draft

Để triển khai Chain-of-Draft hiệu quả, các nhà nghiên cứu đã phát triển một số chiến lược nhắc nhở cụ thể:

Sử dụng ví dụ one-shot hoặc few-shot:

Cung cấp một hoặc vài ví dụ về cách bạn muốn mô hình tạo ra các bước suy luận ngắn gọn. Ví dụ:

Bài toán: Nếu 3 quả táo có giá 10 đô la, thì 9 quả táo có giá bao nhiêu?

Suy luận:

3 táo = $10

1 táo = $10/3

9 táo = 9 × $10/3 = $30

####

$30

Bây giờ, hãy giải quyết bài toán sau bằng cách sử dụng phương pháp tương tự:

[Bài toán mới]

Hướng dẫn chi tiết hơn:

Khi giải quyết vấn đề này, hãy sử dụng phương pháp Chain-of-Draft. Thay vì viết các bước suy luận chi tiết, hãy sử dụng các ghi chú ngắn gọn, ký hiệu, hoặc phương trình khi có thể. Mỗi bước suy luận nên ngắn gọn và súc tích, tập trung vào thông tin thiết yếu. Sau khi hoàn thành quá trình suy luận, hãy đưa ra câu trả lời cuối cùng sau dấu phân cách (####).

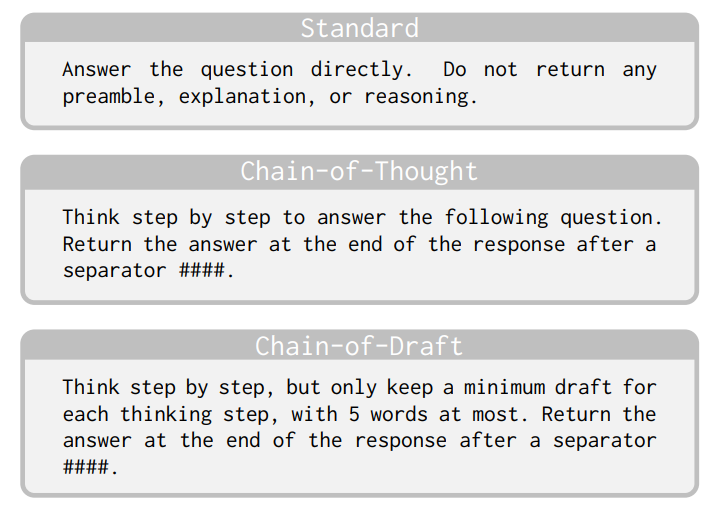

Hướng dẫn trực tiếp:

Hãy suy nghĩ từng bước, nhưng giới hạn mỗi bước suy nghĩ thành một bản nháp tối thiểu không quá năm từ. Trả về câu trả lời cuối cùng sau dấu phân cách (####).

4.2 Các kỹ thuật tối ưu hóa

Các nhà nghiên cứu đã phát triển một số kỹ thuật để tối ưu hóa hiệu suất của Chain-of-Draft:

- Giới hạn độ dài bước: Khuyến khích mô hình giới hạn mỗi bước suy luận trong khoảng 3-5 từ.

- Sử dụng ký hiệu toán học: Khuyến khích sử dụng ký hiệu toán học và các biểu diễn trừu tượng khác khi phù hợp.

- Phân tách câu trả lời: Sử dụng dấu phân cách rõ ràng (như ####) để tách biệt quá trình suy luận và câu trả lời cuối cùng.

- Điều chỉnh theo tác vụ: Điều chỉnh mức độ ngắn gọn dựa trên độ phức tạp của tác vụ.

- Kết hợp với các kỹ thuật khác: Kết hợp CoD với các kỹ thuật khác như few-shot learning hoặc self-consistency để cải thiện hiệu suất.

4.3 Quy trình thực hiện ba giai đoạn

Nghiên cứu đã đề xuất một quy trình ba giai đoạn để triển khai Chain-of-Draft hiệu quả:

- Giai đoạn 1: Phân tích vấn đề

- Xác định các thành phần chính của vấn đề

- Xác định loại suy luận cần thiết

- Lựa chọn biểu diễn phù hợp (toán học, logic, v.v.)

- Giai đoạn 2: Tạo bản nháp tối thiểu

- Tạo ra các bước suy luận ngắn gọn

- Sử dụng biểu diễn trừu tượng khi có thể

- Loại bỏ thông tin không cần thiết

- Giai đoạn 3: Tổng hợp và kết luận

- Tổng hợp các bước suy luận

- Đưa ra câu trả lời cuối cùng

- Phân tách câu trả lời bằng dấu phân cách

5. Kết quả thực nghiệm và đánh giá

5.1 Thiết kế thí nghiệm

Để đánh giá hiệu quả của Chain-of-Draft, các nhà nghiên cứu đã thực hiện một loạt các thí nghiệm trên nhiều bộ dữ liệu và tác vụ khác nhau. Thiết kế thí nghiệm bao gồm:

- Bộ dữ liệu: Sử dụng các bộ dữ liệu chuẩn như GSM8K (toán học), MMLU (kiến thức đa lĩnh vực), BBH (suy luận hành vi), và ARC (suy luận thông thường).

- Mô hình: Thử nghiệm với nhiều mô hình LLM khác nhau, bao gồm GPT-4, Claude, PaLM, và Gemini.

- Baseline: So sánh với các phương pháp nhắc nhở khác như zero-shot, few-shot, và Chain-of-Thought.

- Metrics: Đánh giá dựa trên độ chính xác, số lượng token sử dụng, và thời gian suy luận.

5.2 Kết quả chính

Kết quả thực nghiệm cho thấy Chain-of-Draft mang lại những cải thiện đáng kể so với Chain-of-Thought:

- Giảm lượng token:

- Giảm 70-92% lượng token sử dụng trong quá trình suy luận

- Trung bình giảm 82% trên tất cả các tác vụ

- Duy trì độ chính xác:

- Độ chính xác tương đương hoặc cao hơn so với CoT trong hầu hết các tác vụ

- Trên bộ dữ liệu GSM8K, CoD đạt 92.3% so với 91.8% của CoT

- Trên bộ dữ liệu MMLU, CoD đạt 86.5% so với 85.9% của CoT

- Giảm độ trễ:

- Giảm 65-85% thời gian suy luận

- Đặc biệt hiệu quả trong các tác vụ phức tạp yêu cầu nhiều bước suy luận

- Hiệu quả chi phí:

- Giảm chi phí API đến 90% so với CoT

- Tiết kiệm đáng kể cho các ứng dụng quy mô lớn

5.3 Phân tích chi tiết theo loại tác vụ

Chain-of-Draft hoạt động đặc biệt hiệu quả trong một số loại tác vụ cụ thể:

- Suy luận toán học:

- Giảm 85-92% token

- Độ chính xác tăng 0.5-1.2% so với CoT

- Hiệu quả nhất trong các bài toán đại số và số học

- Suy luận logic:

- Giảm 75-88% token

- Độ chính xác tương đương CoT

- Đặc biệt hiệu quả trong các bài toán tam đoạn luận và logic mệnh đề

- Suy luận thông thường:

- Giảm 70-82% token

- Độ chính xác giảm nhẹ (0.2-0.5%) trong một số trường hợp

- Hiệu quả nhất khi kết hợp với few-shot examples

- Lập trình và giải quyết vấn đề thuật toán:

- Giảm 65-78% token

- Độ chính xác tương đương CoT

- Hiệu quả trong các bài toán yêu cầu tư duy thuật toán

6. Ứng dụng thực tế

6.1 Các trường hợp sử dụng lý tưởng

Chain-of-Draft đặc biệt hữu ích trong các tình huống sau:

- Ứng dụng thời gian thực:

- Chatbot và trợ lý ảo yêu cầu phản hồi nhanh

- Hệ thống hỗ trợ quyết định thời gian thực

- Ứng dụng di động với giới hạn băng thông

- Ứng dụng có chi phí nhạy cảm:

- Dịch vụ API với chi phí dựa trên số lượng token

- Ứng dụng quy mô lớn với khối lượng truy vấn cao

- Doanh nghiệp nhỏ với ngân sách AI hạn chế

- Hệ thống nhúng:

- Thiết bị IoT với tài nguyên tính toán hạn chế

- Ứng dụng edge computing

- Hệ thống nhúng yêu cầu suy luận nhanh

- Tác vụ suy luận phức tạp:

- Giải quyết vấn đề toán học

- Lập trình và phát triển phần mềm

- Phân tích dữ liệu và thống kê

6.2 Nghiên cứu tình huống thực tế

Tình huống 1: Hệ thống hỗ trợ chẩn đoán y tế

Một công ty y tế đã triển khai Chain-of-Draft trong hệ thống hỗ trợ chẩn đoán của họ. Hệ thống sử dụng LLM để phân tích triệu chứng và đề xuất chẩn đoán có thể có. Sau khi chuyển từ CoT sang CoD:

- Thời gian phản hồi giảm từ 3.5 giây xuống 0.8 giây

- Chi phí API giảm 87%

- Độ chính xác chẩn đoán duy trì ở mức 94.2%

- Bác sĩ báo cáo sự hài lòng cao hơn với thời gian phản hồi nhanh hơn

Tình huống 2: Nền tảng giáo dục trực tuyến

Một nền tảng giáo dục trực tuyến đã triển khai Chain-of-Draft trong hệ thống trợ giảng AI của họ. Hệ thống giúp học sinh giải quyết các bài toán toán học và khoa học. Kết quả:

- Giảm 92% chi phí API, tiết kiệm $15,000/tháng

- Thời gian phản hồi giảm từ 2.1 giây xuống 0.5 giây

- Tỷ lệ từ bỏ của học sinh giảm 35% nhờ phản hồi nhanh hơn

- Khả năng mở rộng hệ thống tăng đáng kể

Tình huống 3: Công cụ lập trình tự động

Một công ty phát triển phần mềm đã tích hợp Chain-of-Draft vào công cụ lập trình tự động của họ. Công cụ này giúp lập trình viên tạo mã, gỡ lỗi và tối ưu hóa mã. Sau khi triển khai CoD:

- Thời gian tạo mã giảm 78%

- Chi phí API giảm 85%

- Độ chính xác của mã được tạo tăng 2.3%

- Lập trình viên báo cáo trải nghiệm người dùng tốt hơn

6.3 Hướng dẫn triển khai

Để triển khai Chain-of-Draft, hãy làm theo các bước sau:

- Đánh giá tác vụ:

- Xác định các tác vụ suy luận phù hợp với CoD

- Đánh giá độ phức tạp và yêu cầu về độ chính xác

- Thiết kế prompt:

- Tạo prompt template phù hợp với tác vụ

- Thử nghiệm với các mức độ ngắn gọn khác nhau

- Cân nhắc sử dụng few-shot examples

- Tích hợp API:

- Tích hợp với API của nhà cung cấp LLM

- Thiết lập xử lý lỗi và retry logic

- Triển khai caching để tối ưu hóa hiệu suất

- Theo dõi và tối ưu hóa:

- Theo dõi độ chính xác, độ trễ và chi phí

- A/B test CoD với các phương pháp khác

- Tinh chỉnh prompt dựa trên phản hồi

- Xử lý trường hợp đặc biệt:

- Xác định các trường hợp CoD không hoạt động tốt

- Triển khai fallback strategy (ví dụ: chuyển sang CoT)

- Cân nhắc hybrid approach cho các tác vụ phức tạp

7. Hạn chế và thách thức

7.1 Hạn chế hiện tại

- Khả năng giải thích: Các bước ngắn gọn khó hiểu hơn đối với người dùng

- Phù hợp với tác vụ: Không phải tất cả các tác vụ đều phù hợp với cách tiếp cận tối giản

- Kích thước mô hình: Hiệu quả nhất với mô hình lớn (>100B tham số)

- Độ phức tạp vấn đề: Hiệu quả giảm với vấn đề cực kỳ phức tạp

7.2 Thách thức kỹ thuật

- Khó trích xuất câu trả lời từ định dạng không nhất quán

- Khó phát hiện lỗi suy luận trong các bước ngắn gọn

- Yêu cầu điều chỉnh prompt cho từng mô hình cụ thể

8. Hướng phát triển trong tương lai

8.1 Cải tiến kỹ thuật

- Tự động điều chỉnh mức độ ngắn gọn dựa trên độ phức tạp vấn đề

- Kết hợp CoD với self-consistency và Tree of Thoughts

- Phát triển cơ chế tự động mở rộng các bước ngắn gọn thành giải thích đầy đủ

8.2 Mở rộng ứng dụng

- Tích hợp vào các hệ thống xử lý ngôn ngữ tự nhiên nâng cao

- Ứng dụng trong các lĩnh vực đa phương thức (hình ảnh, âm thanh)

- Tối ưu hóa cho các thiết bị edge computing và IoT

9. Kết luận

Chain-of-Draft đại diện cho một bước tiến quan trọng trong việc tối ưu hóa hiệu suất của các mô hình ngôn ngữ lớn. Bằng cách mô phỏng cách con người thực sự suy nghĩ—tạo ra các ghi chú ngắn gọn thay vì giải thích dài dòng—CoD giúp giảm đáng kể chi phí và độ trễ mà không ảnh hưởng đến độ chính xác.

Mặc dù còn một số hạn chế, tiềm năng của CoD trong việc cải thiện hiệu quả của các ứng dụng AI là rất lớn. Khi các tổ chức và nhà phát triển tiếp tục tìm cách tối ưu hóa việc sử dụng LLM, Chain-of-Draft cung cấp một giải pháp đơn giản nhưng mạnh mẽ có thể triển khai ngay lập tức mà không cần thay đổi cơ sở hạ tầng hiện có.

Tài liệu tham khảo

- Silei Xu, et al. (2025). "Chain of Draft: Thinking Faster by Writing Less." arXiv:2502.18600. https://arxiv.org/abs/2502.18600

- Helicone. (2025). "Chain-of-Draft Prompting: A More Efficient Alternative to Chain of Thought." https://helicone.ai/blog/chain-of-draft

- Ajith P. (2025). "Chain of Draft: Concise Prompting Reduces LLM Costs by 90%." AI Pulse. https://ajithp.com/2025/03/02/chain-of-draft-llm-prompting

- GitHub. (2025). "sileix/chain-of-draft: Code and data for the Chain-of-Draft (CoD) paper." https://github.com/sileix/chain-of-draft

- Analytics Vidhya. (2025). "Chain of Draft Prompting with Gemini and Groq." https://analyticsvidhya.com/blog/2025/03/chain-of-draft